Transformation digitale

Comment s'organiser pour télétravailler efficacement

Paris, le 29 mars 2020

Crise du Covid-19 oblige, nous voilà confinés depuis déjà 2 semaines. Et il a bien fallu apprendre à travailler à distance, depuis sa maison. Nous avons reçu quelques conseils pour bien s'organiser. J'en ai expérimenté quelques uns, j'en ai partagé d'autres. J'en ai faite une petite compilation.

1 - Garder la forme et mettre les formes

Vous connaissez tous cette fameuse citation, « Mens sana in corpore sano » ou « Un esprit sain dans un corps sain. ». Elle est issue de la dixième Satire de Juvénal. Oui je sais, cela vous fait une belle jambe. Justement, parlons-en. Pour garder la forme, il faut l'entretenir.

Ce n'est pas parce qu'on est confiné chez soi qu'il ne faut pas faire un minimum d'exercice, oublier de se raser ou de se brosser les dents. Rester en pyjama toute la journée n'est pas une option non plus. Il est donc important de conserver ces gestes du quotidien : faire sa toilette, se raser (pour les hommes), se maquiller (pour les femmes), s'habiller.

Conserver ces rituels liés au travail est important, car sinon la séparation entre vie professionnelle et vie personnelle s'estompe. Et on commence à tout mélanger. Un sentiment diffu d'être en vacances peut s'installer, avec malheureusement les contraintes dû au travail, et cet écart finit par créer un malaise.

Il faut aussi pouvoir se ménager un ou plusieurs créneaux pendant la journée pour faire un peu d'exercice. Une heure par jour suffit. Si vous le pouvez, profitez également du beau temps en sortant vous aérer sur votre balcon, ou dans votre jardin si vous avez la chance d'en avoir un. Rappelons qu'une heure de jardinage permet de bruler plus de calories qu'une séance de sport. Alors comme c'est le printemps, profitez-en.

2 - Aménager son environnement de (télé)travail

Travailler de chez soi depuis son canapé, on peut le faire pendant une petite heure ou deux. Mais passer toute la journée devant son ordinateur, en vidéoconférence ou au téléphone, ce n'est plus la même histoire. Il est alors indispensable d'aménager sa maison pour se constituer un petit espace à soi ou presque.

Plus facile à dire qu'à faire, surtout si l'on ne dispose pas d'une pièce dédiée à cet effet. Si vous ne disposez pas d'un bureau, vous pouvez encore requisitionner un bout de la table de la salle à manger, ou de la table basse du salon (moins confortable), ou investir les combles que vous venez de faire aménager, ou bien encore votre sous-sol.

Si vous vous installez dans une salle commune comme le salon, ou si vous partagez votre bureau avec votre conjoint ou conjointe, prévoyez des systèmes vous permettant de vous isoler pour travailler plus sereinement. Equipez-vous par exemple d'un casque à réduction de bruit active, du type Bose Headphones 700, Sony WH-1000XM3 (le 4 est en approche) ou Jabra Elite 85H. J'ai à ce propos écrit un article sur l'utilisation du Bose pour participer à des vidéoconférences.

Il faut aussi pouvoir compter sur un réseau domestique performant. Réseau domestique basé sur le WiFi ou câblé (il suffit de se brancher directement sur sa box Internet) et sur une connexion Internet haut débit (Fibre Optique ou ADSL).

J'avais écrit, il y a un bon moment déjà (whaou, 4 ans déjà), un petit article sur la meilleure façon de distribuer le WiFi dans sa maison. Les conseils que j'y donne sont toujours valables, même si à cette époque, les réseaux WiFi Mesh (réseaux maillés) n'existaient pas encore.

Si votre réseau WiFi sature, notamment parce que vos enfants suivent leurs cours sur Internet, que votre conjoint participe à une vidéoconférence en même temps que vous, sachez qu'aujourd'hui, il existe des réseaux WiFi Mesh tri-bandes (comme les Netgear Orbi, Asus ZenWiFi CT8/XT8, Linksys Velop), avec une bande dédiée pour la communication entre amplificateurs, laissant les 2 autres bandes de 2,4 Ghz et 5 Ghz disponibles pour les équipements domestiques et offrant ainsi des débits importants compatibles avec la vidéo (et donc la vidéoconférence). Je vous explique tout et comment optimiser la couverture de réseau WiFi dans cet article.

Exemple de réseaux WiFi maillés

Il vous faut naturellement un PC portable ou fixe et si possible un 2ème écran, plus grand que le simple écran de votre portable. Ceci vous permettra d'afficher des documents tout en travaillant par ailleurs sur votre messagerie ou en vidéoconférence.

3 - Utiliser les bons outils au bon moment

Messagerie électronique, vidéoconférence, téléphone, les outils collaboratifs ne manquent pas. Mais encore faut-il savoir les utiliser à bon escient. Voici donc un petit tour d'horizon et quelques conseils de bon sens, que nous appliquons tous généralement de façon assez intuitive.

- Le téléphone (fixe ou mobile) : un appel est généralement intrusif et oblige votre correspondant à interrompre son travail. Réservez-le aux sujets urgents et importants ;

- La messagerie instantanée ou Chat (Google Hangouts, Microsoft Teams, WhatsApp, Messenger, Slack, Discord, RocketChat, etc.) : elle présente l'avantage d'échanger par écrit et en mode synchrone (votre correspondant vous répond généralement immédiatement) ou au pire en mode asynchrone (il répondra quand il sera disponible, mais dans ces cas là, autant utiliser la messagerie) ;

- La visioconférence* (Google Meet, Microsoft Teams ou Skype, Zoom, Cisco WebEx, ou les outils sur smartphones comme WhatsApp, Messenger, Facetime, Google Duo) : elle permet d'organiser des réunions dans lesquelles vous pourrez vous voir, partager des documents ou votre écran. Privilégiez des formats courts (1 heure max), opérationnels avec un ordre du jour, un plan d'actions et établissez un compte-rendu (comme d'habitude bien sûr);

- La messagerie électronique ou mail (Office365, GMail, Lotus, etc.) : utilisez le mail pour des sujets complexes qui nécessitent de conserver un écrit.

En sus de ces outils de communication, privilégiez les outils collaboratifs :

- Les documents partagés (Google GSuite ou Miscosoft Office365) : Ces outils permettent de collaborer simultanément dans un même document partagé dans le Cloud, que ce soit un document Word/Doc, une présentation Powerpoint/Slides ou une feuille Excel/Sheet.

- Les tableaux blancs (Microsoft Teams - tableau blanc intégré - ou Google Jamboard) : ces outils permettent de dessiner, coller des post-it, écrire, comme sur un vrai tableau de salle de réunion. Rappelonns qu'un dessin vaut mieux qu'un long discours.

- Les tableaux Kanban (Trello, Asana ou Wekan - si votre entreprise a mis cet outil en oeuvre) : organisez votre travail d'équipe à travers des tableaux partagés.

- Les drives (espace de stockage dans le Cloud comme Microsoft OneDrive, Google Drive, DropBox, Box, etc.) : échangez des documents volumineux ou non en toute confidentialité.

(*) Pour profiter de la visioconférence, il faut naturellement disposer d'une WebCam sur son PC Portable. Et espérer que tous vos correspondants disposent d'un équipement similaire. Mais tout le monde dispose d'un smartphone, et donc d'une caméra et d'une app de visioconférence.

Si vos correspondants ont encore la chance de pouvoir se réunir dans une salle de réunion (en respectant les distances de sécurité), ils devront également utiliser le même système de visioconférence, avec en complément une caméra 360 avec focus automatique sur l'intervenant, telle que Owl Meeting Pro.

4 - Appliquer les bonnes pratiques

Disposer d'un bureau et des bons outils ne suffit malheureusement pas à se sentir à l'aise en télétravail. Comme disait Aristote, « l'homme est un animal social ». Notre cerveau comporte des neurones miroirs qui nous permettent spontanément d’entrer en empathie avec d’autres. Cette empathie nous nourrit, elle génère un confort, une appartenance, élargit le corps social au vivant. Elle cultive notre intuition.

En télétravail, nous sommes isolés même si connectés en permanence. Il faut donc restaurer les relations sociales en instituant quelques rituels. Ils peuvent vous paraître futiles, mais ils sont en réalité très importants.

- Dites bonjour le matin à votre groupe / équipe, de préférence à travers la messagerie instantanée (Chat).

- Faites un point régulier, ne serait-ce qu'une demi-heure et instaurez un rituel régulier tous les jours.

- Faire des pauses pendant la journée, et instaurez une « télépause café » avec vos collègues. Sachez que le fait de travailler sans voir vos interlocuteurs vous impose une charge cognitive plus importante que d'habitude. Votre cerveau travaille en effet pour imaginer votre interlocuteur.

Le télétravail introduit aussi un flou entre le monde professionnel et personnel. Car vous travaillez maintenant chez vous. Il faut donc réintroduire une séparation symbolique entre vos activités professionnelles et personnelles, par exemple en fermant complètement votre ordinateur à 18 heures et en désactivant les applications de travail de votre téléphone.

Car votre cerveau a besoin de déconnecter pour bien fonctionner. Ne pas déconnecter vous expose à une baisse significative de votre efficacité au travail. C'est d'ailleurs pour cela que le législateur à introduit un droit à la déconnexion.

Le droit à la déconnexion permet à chaque collaborateur de ne pas se connecter aux outils numériques, lire et/ou répondre aux mails, SMS ou appels en dehors des horaires habituels de travail et ce, afin d’assurer le respect des temps de repos.

5 - En conclusion

Voilà à ce jour mes conseils pour bien télétravailler. Ils ne constituent évidemment pas une liste exhaustive des bonnes pratiques. Si vous avez vous même des conseils à suggérer, n'hésitez pas à laisser un commentaire.

Et en bonus, un peu d'humour

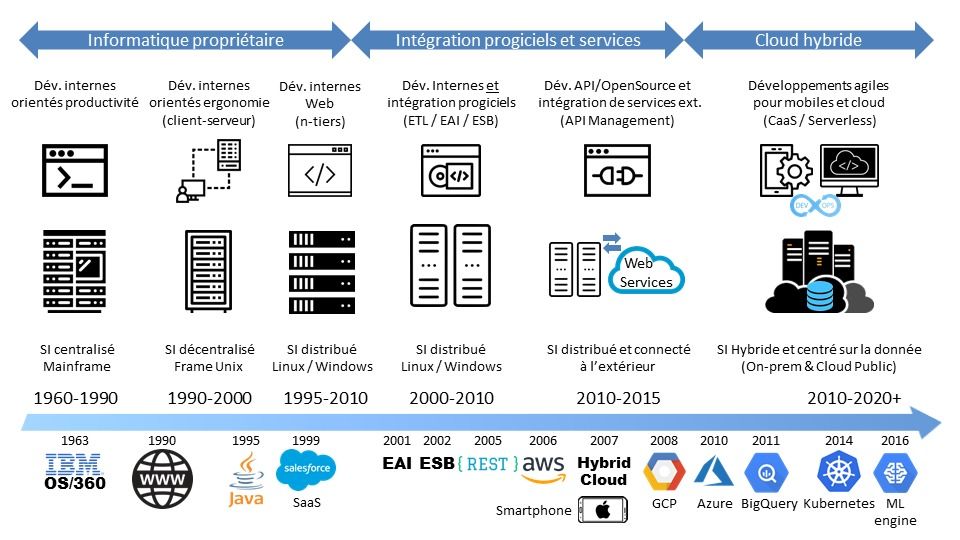

Les grandes évolutions du Système d'Information

Paris, le 14 août 2019

Retracer les évolutions des Système d'Information (SI) est un exercice des plus classiques. Tous les cabinets de conseil dignes de ce nom pourront vous en parler. Alors dans ce petit billet, j'ai essayé de faire différemment : j'ai fait tenir cette évolution dans une seule figure.

C'est donc forcément une analyse très macroscopique. Mais cela permet de voir d'où on vient et vers où on va en matière de SI.

Une évolution en trois phases

J'ai pour ma part identifié à ce jour trois grandes phases d'évolution du SI. A l'intérieur de chaque phase, on trouvera des évolutions structurantes bien sûr, mais qui n'ont pas fondamentalement changé la façon dont le SI fonctionnait.

1 ère phase : le SI propriétaire

Chaque entreprise, pour répondre à ses besoins, a développé ses applications et construit, brique fonctionnelle par brique fonctionnelle et serveur par serveur, son Système d'Information.

Chaque SI s'est bien sûr construit sur la base des technologies existantes de son époque. Dans les années 70, le langage de programmation Cobol et les mainframes dominaient, que ce soit ceux d'IBM, Unisys, Fujitsu, HP ou même Bull et son système d'exploitation GCOS.

Dans les années 90, les serveurs Unix ont pris le pas, et on a commencé à voir d'autres architectures apparaître : le client-serveur (que l'on a appelé rétrospectivement architecture 2-tiers) puis les architectures Web de type 3-tiers et n-tiers poussées par l'avènement d'Internet et l'apparition des langages de programmation Java et C#.

Passer des architectures monolithiques mainframe au client-serveur puis aux architectures n-tiers a demandé de très grosses évolutions technologiques. Mais cela n'a pas fondamentalement changé la façon dont on pensait le Système d'Information. Le SI était avant tout composé d'applications développées en interne avec peu d'interaction avec les autres systèmes.

2 ème phase : le SI intégré

Le passage à l'an 2000 a fait peur à tout le monde ; A tout le moins à ceux qui utilisaient l'informatique dans leur vie quotidienne. La plupart des programmes n'utilisaient alors que des dates codées sur 2 chiffres. Il a donc fallu, pour ceux qui s'en souviennent encore, engager des travaux de modernisation du SI. C'est alors que les progiciels et notamment les ERP (Enterprise Resource Planning ou Progiciel de Gestion Intégré en bon français) ont commencé à prendre une place prédominante, en remplaçant les vieux logiciels obsolètes dépassés par l'an 2000.

Il a donc fallu intégrer ces progiciels au reste du SI. Avec des applications désormais distribuées sur différents serveurs. Voire sur des serveurs virtualisés (VM). On a donc inventé des solutions comme l'EAI (Enterprise Application Integration) puis quand les interfaces Web se sont généralisées l'ESB (Enterprise Service Bus).

Et avec des interfaces Web et un réseau Internet plus fiable, on s'est aperçu qu'on pouvait faire de l'EDI (Echange de Données Informatisé) pour beaucoup moins cher et plus rapidement. On a donc commencé à intégrer les WebServices d'autres partenaires ou fournisseurs à son propre SI.

Plutôt que de développer des applications propriétaires, on a donc conçu le SI en pensant ses interfaces, ces fameuses API (Application Program Interface), permettant de communiquer tant en interne, entre le front office et le back office, qu'en externe avec d'autres SI. Avec en point central, la gestion de ces API : l'API Management, et un protocole simple : REST (REpresentational State Transfer).

3 ème phase : le SI hybride

Créer des API pour permettre à ses applications de communiquer, c'est bien. Mais généraliser les API à tout son SI, c'est encore mieux. C'est ce qui a donné naissance au Cloud et à l'automatisation d'un grand nombre d'opérations. Désormais, on ne gère plus son infrastructure par ses composants, mais par du code.

Le Cloud Public a-t-il pour autant changé notre façon de concevoir le SI ?

La réponse est non si l'on utilise le Cloud en mode IaaS (Infrastructure as a Service). Dans ce mode, l'entreprise loue des machines virtuels (VM) à son fournisseur et vient simplement installer ses applications dessus. Elle y gagne en souplesse, mais la location à long terme peut lui revenir plus cher que l'achat de serveurs en propre. Faire des économies avec le IaaS demande une gestion fine de sa capacité : il faut savoir couper les serveurs inutilisés (la nuit par exemple) et n'allouer des ressources qu'en cas de demande forte.

NB : Le mode PaaS (Platform as a Service) s'avère économiquement plus intéressant car il permet à l'entreprise de s'affranchir de toute la maintenance de la pile logiciel et du middleware, prise en charge par le fournisseur de Cloud. Mais il demande un peu de discipline car il faut naturellement que vos applications suivent les montées de version du fournisseur.

La réponse est oui si l'on commence à concevoir son SI en terme de progiciels loués en mode SaaS (Software as a Service), de micro-services, de conteneurs et d'application serverless (sans serveur). Tout en intégrant un maximum de services de son fournisseur, comme le Machine Learning, le BigData, la BlockChain, etc., et en veillant à ne pas créer trop d'adhérence entre son fournisseur et son SI.

Concevoir son SI n'est plus une histoire d'intégration de progiciels et d'API. Il s'agit plutôt d'intégrer des applications en mode SaaS avec ses propres applications, conçues en mode micro-services et Serverless. Ce terme barbare ne signifie pas que le serveur a disparu. Non, les ressources sont simplement allouées dynamiquement par le fournisseur de cloud au moment de l'exécution du code. Et vous ne payez qu'à l'usage réel (pay-as-you-go). Ce qui vous évite de réfléchir aux règles liées à l'élasticité (auto-scaling) de votre infrastructure, tout étant géré par le Cloud. Et ce n'est plus la fonction mais la donnée qui devient la brique première de votre SI.

On peut aussi coupler son code serverless à des micro-services hébergés dans des conteneurs, gérés par Kubernetes (le gestionnaire de conteneur le plus populaire loin devant Mesos ou Docker Swarm) en mode CaaS (Container as a Service).

Et comme le SI est encore en grande partie on-premise, il faut pouvoir gérer le mélange des genres, à savoir un SI hybride, hébergé dans le Cloud Public et dans des centres de traitement traditionnels. Car tout ne passera pas dans le Cloud Public quoiqu'on puisse en dire.

Les 3 phases du SI

Windows Mobile est-il vraiment mort ?

Microsoft Lumia 950

Si on examine les parts de marchés des OS mobiles, on s’aperçoit que Android se taille la part du lion avec 81,7% de part de marché, loin devant iOS avec 17,9% et Windows Mobile avec un ridicule 0,3%. D'aucuns diraient donc que Windows Mobile est mort et bientôt enterré. Surtout que Microsoft a fermé son activité Mobile rachetée à Nokia en 2014 et licencié les 9 650 salariés travaillant pour cette division, en deux vagues entre juillet 2015 et mai 2016, laissant ses partenaires poursuivre le combat. Mais le canard est-il déjà mort ? Pas si sûr...

La part de marché des smartphones

Si l'on en croit un récente étude du Gartner, Android se taille la part du lion avec 81,7% de parts de marché (en légère progression), loin devant iOS avec 17,9% (stable) et Windows Mobile avec 0,3% (en forte régression).

|

Operating System |

Unités vendues 4T16 (Milliers) |

Part de marché 4T16 (%) | Unités vendues 4T15 (Milliers) | Part de marché 4T15 (%) |

| Android | 352 670 | 81,7 | 325 394 | 80,7 |

| iOS |

77 039 |

17,9 |

71 526 |

17,7 |

| Windows |

1 092 |

0,3 |

4 395 |

1,1 |

| BlackBerry |

208 |

0,0 |

907 |

0,2 |

|

Other OS |

530 |

0,1 |

887 |

0,2 |

|

Total |

431 539 |

100,0 |

403 109 |

100,0 |

Source: Gartner (Février 2017)

Les fameux BlackBerry et leurs célèbres claviers ont quasiment disparus du radar avec une part de marché proche de 0 et 200 000 unités vendus seulement (tous pays confondus !). On peut donc légitimement se dire que Windows Mobile est en train de suivre le même chemin que les Blackberry. Sans même avoir connu d'heures de gloire, contrairement au constructeur canadien. La faute entre autres au catalogue d'applications qui peine toujours à se remplir face à celui d'Android et iOS, et à un OS qui est arrivé bien trop tard à maturité face à ses concurrents.

Ce qui nous conduirait à une sorte de duopole formé du couple Android – iOS, ce qui est toujours dommageable pour la concurrence et l’innovation. Quoique si l’on regarde de plus près, les constructeurs de smartphones sous Android (Samsung, et les chinois Huawei, Oppo et BBK en tête) se livrent une concurrence assez féroce.

| Constructeur |

Unités vendues 2016 (Milliers) |

Part de marché 2016 (%) |

Unités vendues 2015 (Milliers) |

Part de marché 2015 (%) |

| Samsung |

306 447 |

20,5 |

320 220 |

22,5 |

| Apple |

216 064 |

14,4 |

225 851 |

15,9 |

| Huawei |

132 825 |

8,9 |

104 095 |

7,3 |

| Oppo |

85 300 |

5,7 |

39 489 |

2.8 |

|

BBK Communication Equipment |

72 409 |

4,8 |

35 291 |

2.5 |

| Others |

682 314 |

45,6 |

698 955 |

49,1 |

| Total |

1 495 358 |

100,0 |

1 423 900 |

100,0 |

Source: Gartner (Février 2017)

A noter que le dernier trimestre 2016 a vu Apple repasser devant Samsung, une remontée sans doute liée à l’effet du Galaxy Note 7 et de ses batteries explosives. Mais cette lutte acharnée se joue sans le constructeur américain de Redmond. Microsoft a-t-il pour autant abandonné tout espoir de jouer un rôle dans le marché du smartphone ? Pas si sûr que cela, et voilà pourquoi.

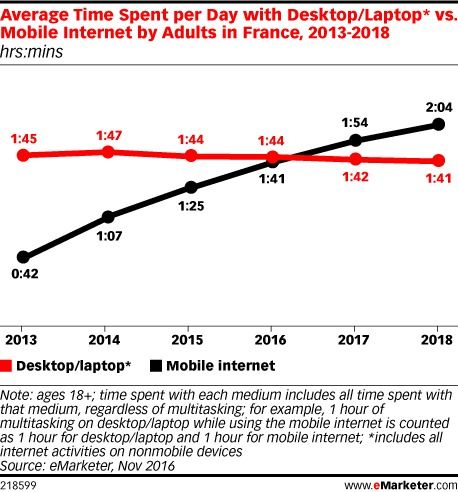

Le smartphone est le terminal informatique de demain

En 2013, les internautes français passaient 1h45 par jour sur Internet en version desktop (ordinateur de bureau ou ordinateur portable). Cette durée est restée stable (1h44 en 2016) et les projections sont donc sans surprises (1h41 en 2018).

Et pendant ce temps, le temps passé sur l’Internet mobile explose. En 2013, eMarketer estimait que les internautes passaient 42 minutes par jour sur leur mobile pour consulter Internet, et 1h41 en 2016. L’an prochain, le temps passé sur l’Internet mobile aura dépassé le desktop. En 2018, on passera sans doute plus de 2 heures par jour sur notre mobile à naviguer sur Internet.

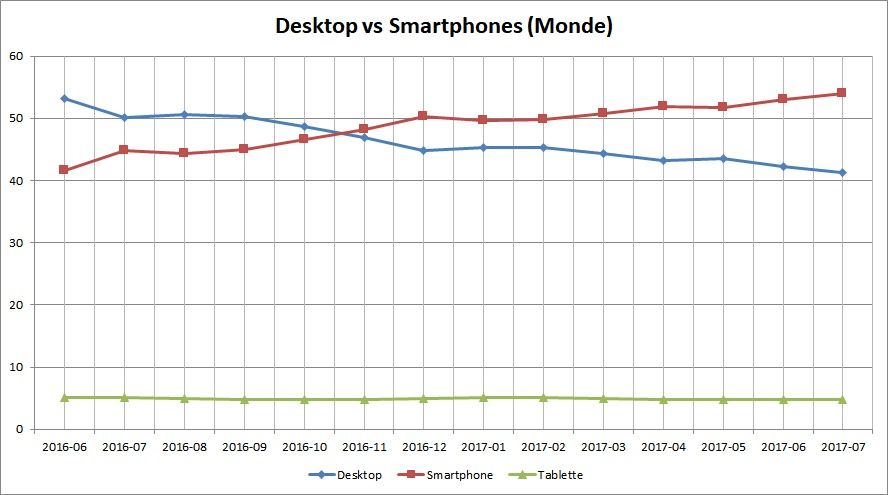

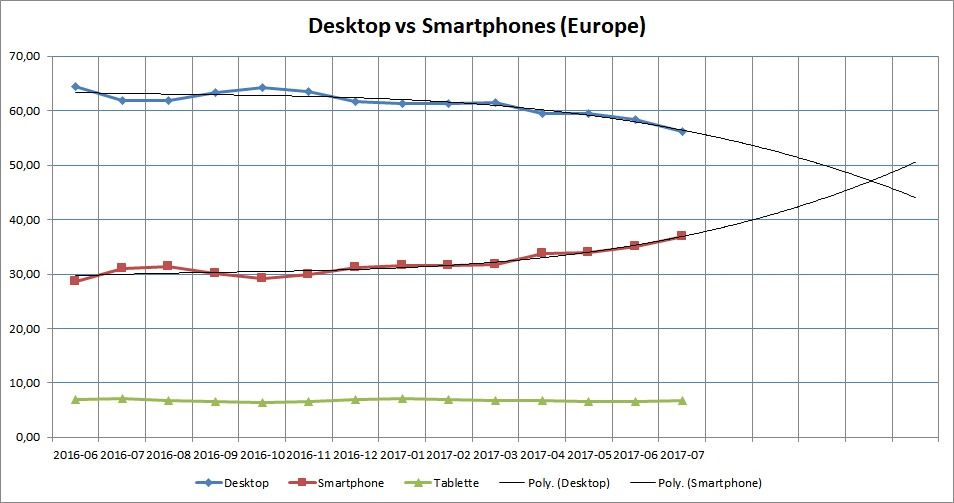

Des chiffres corroborés par les statistiques mondiales de StatCounter : ces dernières comptent simplement le nombre d’équipements et les classent par catégorie (Desktop, Tablette, Smartphone) indépendamment du taux d’usage dudit équipement. On peut donc se servir une fois par semaine de son PC portable et tous les jours de son smartphone, StatCounter comptera 1 Desktop et 1 mobile.

On voir donc qu’au niveau monde, le nombre de smartphones a doublé celui de Desktop en novembre 2016 et qu’il continue de croître (tandis que le nombre de tablettes stagne).

Ces chiffres sont à moduler au niveau de l’Europe. Globalement, le desktop reste majoritaire avec 56,17% des équipements recensés (en décroissance) contre 37% pour les mobiles (en croissance). Les courbes ne se croiseront donc a priori que fin 2017 – début 2018, avec un an de retard par rapport à la majorité de la planète.

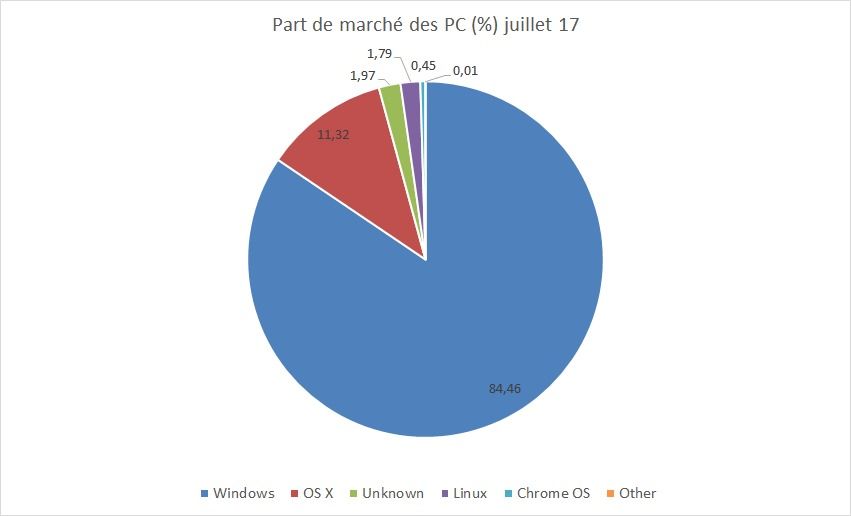

Tous ces chiffres montrent simplement une chose : le smartphone est en train de supplanter le PC comme terminal informatique. Or Microsoft est ultra majoritaire dans le monde des PC avec plus de 84% de part de marché (stable). Si le PC disparait, et si Microsoft ne change pas, alors Microsoft disparaitra avec lui.

Dit autrement, Android est en train de supplanter Windows dans nos usages. Microsoft a donc le choix entre abandonner le PC qui reste à ce jour sa vache à lait, et changer de métier (car c’est en maîtrisant l’OS que Microsoft peut se permettre de dominer largement le monde du logiciel) ou se battre pour exister sur ce marché, mais avec une nouvelle offre vraiment différenciatrice et pas simplement similaire à celle d’Apple et de Samsung.

Des entreprises ayant radicalement changé de métier, on en connait : Hewlett Packard a bien commencé par fabriquer des instruments électroniques (oscilloscopes, calculatrices) avant de devenir un constructeur informatique. Ou encore Nokia, qui fabriquait à l’origine (en 1865-1871) du papier, avant de se développer dans le caoutchouc, le câble et l’électronique, bien avant de connaitre le numéro 1 mondial de la téléphonie mobile, de 1992 à 2011.

Mais tout porte à croire que Microsoft n’a pas lâché la partie. Le succès qu’il a rencontré avec sa surface, concept hybride entre l’ordinateur et la tablette, ayant donné naissance au PC 2-en-1, le pousse à chercher une autre voie dans le domaine des smartphones. D’aucuns auront ainsi annoncé un surface phone, pour surfer sur le succès de la surface. Mais rebaptiser un produit d’un nouveau nom n’est pas en soi révolutionnaire ni disruptif pour employer un nom à la mode. Microsoft cherche de nouveaux usages.

Et Microsoft pense en avoir trouvé un avec son concept « Continuum », qui permet à l’utilisateur de continuer à travailler avec son téléphone portable comme s’il avait un PC. Il suffit de pouvoir connecter un écran, un clavier et une souris à son téléphone pour bénéficier d’un grand écran et d’une saisie plus rapide. Ceci vous permet d’accéder rapidement à vos e-mails, vos photos, votre navigateur et des applications comme les réseaux sociaux ou Office.

Le produit le plus avancé matérialisant ce concept reste le HP Elite X3, qui propose un Desk Dock (station d’accueil qui permet de brancher clavier, souris et écran au smartphone) et un Lap Dock (une sorte d’ultrabook, mais sans RAM, sans CPU et sans disque ; juste un clavier et un écran). Un trio qui promet d'obtenir un smartphone, un PC de bureau et un ordinateur portable. Un 3-en-1 prometteur mais encore plombé par les manques de Windows 10 Mobile et des limites de continuum.

L’usage de Continuum reste en effet limité à la navigation Internet, aux e-mails et à l'utilisation d’Office (documents Word, tableaux Excel, présentations Powerpoint). Mais ce n’est déjà pas si mal car ce sont les principales applications utilisées sur PC. Mais le minimum serait d’avoir un niveau de performance aussi proche possible que celui d’un PC.

Or Windows 10 Mobile ne fonctionne à ce jour que sur des processeurs spécifiques aux smartphones. Les puces des constructeurs, comme les Exynos de Samsung, intègrent toutes généralement un processeur Cortex, d’ARM, le concepteur de l’architecture. Il existe aussi des constructeurs qui conçoivent leurs propres processeurs et puces comme Qualcomm avec ses Snapdragon, basés sur une architecture ARM, Intel et ses puces Atom basés sur une architecture x86 (mais Intel vient de jeter l’éponge), Apple et ses puces A8, A10, etc, tous basés eux aussi sur ARM.

Pour faire tourner correctement une application sous Windows 10 Mobile, il faut donc faire un effort particulier d’adaptation pour coller à l’architecture ARM et à Windows 10 Mobile. Sans doute un de trop pour la plupart des développeurs, déjà bien occupés avec Android et iOS. Ce qui fait que la plupart des applications sous Windows 10 Mobile affichent des performances lamentables alors que sur PC, elles sont tout à fait au point.

Mais Microsoft continue à travailler sur son concept en essayant de gommer les principaux défauts de son concept actuel. Voici trois raisons qui nous poussent à dire qe Microsoft persiste :

-

Windows 10 (la version desktop et non la version Mobile) revient sur processeurs ARM et relance la course à l’ARMement. On se souvient du cuisant échec de la Surface RT, fonctionnant sous un Windows 8 (trop) spécifique pour ARM. Microsoft en a tiré les leçons et reviendra en 2018 avec un Windows 10 compatible supportant ARM et faisant tourner toutes les applications universelles ainsi que les applications historiques propres à l’architecture x86. Microsoft a beau expliquer que cette version ne sera homologuée que pour PC, et non pour smartphones, le seul intérêt de rendre Windows compatible avec ARM est de pouvoir attaquer le marché des mobiles. On peut donc espérer qu’une fois cette version de Windows 10 sortie, de nouveaux smartphones sortent, avec l’ensemble du catalogue Windows…Voilà le problème de la pauvreté du catalogue des applications réglé, ainsi que le problème des performances sous Windows Mobile : il n’y a plus d’adaptations à faire, c’est l’OS qui s’est adapté.

-

La prochaine mise à jour majeure de Windows 10, qui arrivera cet automne - proposera la fonction « Phone » aux possesseurs de smartphones Android et autres iPhone (soit 99,9% du marché). Cette application permettra de continuer à naviguer sur Internet depuis son PC, après avoir commencé sur son smartphone. Il suffira de partager la page que l’on consulte sur smartphone et de choisir l’app « Continuer sur PC » pour que celle-ci se retrouve sur son PC. Il s’agit d’une sorte de Continuum lite sur iOS et Android en somme et une façon d’habituer les utilisateurs à des liens renforcés entre smartphone et PC.

-

Le concept de Continuum est aussi copiée par la société chinoise Jide, qui annonce Remix Singularity, une application qui permettrait de transformer son smartphone Android en PC (similaire à Chrome OS) avec toutes les applications Android dessus. Comme Continuum, on pourra brancher un clavier, un écran et une souris sur son smartphone. Le concept semble donc avoir du bon.

Conclusion

Si le smartphone est bien le terminal informatique de demain, et si Microsoft veut encore espérer y jouer un rôle, il est indispensable pour ce dernier de revenir sur le marché avec un concept innovant (même s’il ne sera pas aussi disruptif que Microsoft aimerait le faire croire). Le fait que Microsoft travaille à rendre Windows 10 totalement opérationnel sur ARM dessine une stratégie assez claire :

-

Disposer d’un OS universel fonctionnant sous les 2 architectures du marché : Intel x86 (architecture CISC, omniprésente sur le marché du PC) et ARM Cortex (architecture RISC, omniprésente sur le marché des smartphones).

-

Réinvestir le marché des smartphones avec de nouveaux produits, qui pour perturber le mastodonte Android, doivent apporter un gros plus.

-

Ce plus serait un 2 ou 3 en 1, à l’image de la Surface qui propose à la fois une tablette et un PC. Microsoft pourrait ainsi proposer un smartphone qui serait aussi un PC (et éventuellement un portable) grâce à un Continuum enfin débarrassé des limites de Windows Mobile et de sa pauvreté d’applications.

Si malgré tout cela, les clients ne reviennent pas, Microsoft n'aura plus qu'à jeter l'éponger et changer de métier. Comme devenir le premier acteur dans le Cloud Computing par exemple.

Agences bancaires : se transformer ou disparaitre

L'information publiée par le journal "Les Echos" le 29 septembre et confirmée depuis par des sources syndicales a fait le buzz : la Société Générale envisagerait de fermer 400 de ses 2 221 agences que compte la banque en France, et ce d'ici à 2020, soit quasiment 20% de son réseau en 5 ans. Un régime draconien qui se traduira probablement par quelques milliers de suppressions de postes. Du coup, la nouvelle était sur toutes les lèvres, et jusque dans l'intervention de Benoit Legrand, Président de ING France, au Salon Banque et Innovation qui s'est tenu le 1er octobre dans les salons de l'hôtel des Arts et Métiers. Il peut sourire, ING Direct est une banque en ligne et n'a aucune agence. Quant à ING Commercial Banking, la banque de financement et d'investissement dédiée aux grandes entreprises et institutions françaises, elle n'a pas ce genre de problème.

La réduction du nombre d'agences, un mouvement inexorable

La Société Générale n'est pas la seule à réduire la voilure de son réseau de distribution, ni la première. Le Crédit agricole a fermé 50 de ses 325 agences en Ile-de-France, BNP Paribas a fait de même avec 14 agences fermées sur 200 à Paris en 2014. Et le Crédit lyonnais prévoit de supprimer 1 000 postes d’ici 2018, avec à la clef des fermetures d’agences. Le mouvement ne se limite pas d'ailleurs pas qu'à la France. La Deutsch Bank envisagerait de supprimer un quart de ses effectifs. Quant à HSBC, elle annonçait début juin une réduction de ses effectifs de 10%, soit entre 22 000 et 25 000 suppression d'emplois.

En 2009, Le Figaro évoquait déjà la fermeture de 1 000 agences bancaires en France ; On ne parlait pas encore de transformation digitale, même si la banque en ligne et les guichets automatiques étaient déjà bien présents dans les esprits, mais plutôt de surdensité du réseau ; En 2009, la France comptait 1 agence pour 1 607 habitants alors que la moyenne des 27 pays européens était de 2 123 habitants. Nous étions très loin derrière les Pays-Bas, la Grande-Bretagne, ou encore la Suède, qui comptaient respectivement une agence pour 4 544, 4 892 et 4 956 habitants (soit une densité trois fois inférieure). Et ce n'est pas une exception culturelle spécifique à ces pays : les banques néerlandaises ont par exemple réduit le nombre de leurs agences bancaires de 50% en 10 ans et réduit leurs effectifs de 9% (source ING).

Mais les banques françaises avancent plus doucement sur le sujet car elles veulent avant tout éviter des plans de départs qui affecteraient leur réputation. Alors que réorganisations et départs à la retraite - nous sommes entrés dans le papy-boom - permettraient de supprimer 10 à 15% des agences sans faire de vague. Les agences des zones rurales, comptant moins de 4 collaborateurs, sont légion et sont les candidates idéales car peu rentables et sans grand impact social, même si pour certaines banques, ces agences représentent aussi leur image de marque.

Pourquoi fermer les agences ?

Les agences ferment car elles sont tout simplement désertées par leurs clients. Ces derniers fréquentent de moins en moins leurs agences bancaires et utilisent de plus en plus les services en ligne. Des services de plus en plus mobiles et de moins en moins "Internet fixe". Ce que confirment les chiffres fournis par les banques et les sociétés de conseil : en 2007, les clients français de la Société Générale étaient 57% à se rendre au moins une fois par mois dans une agence ; En 2015, ils ne sont plus que 42%. Même tendance du côté de LCL, qui a vu la fréquentation de ses agences chuter de 30% en cinq ans. Une tendance confirmée par la 5eme édition de l'étude du cabinet Deloitte sur la relation banque-clients, publiée le 15 septembre, montrant que le nombre de clients ne se rendant jamais en agences était passé de 14% en 2014 à 24% en 2015. En fait, la fréquentation des agences baisse de 5% par an depuis bientôt 10 ans, et cela va plutôt en s'accélérant.

La concurrence de la banque en ligne

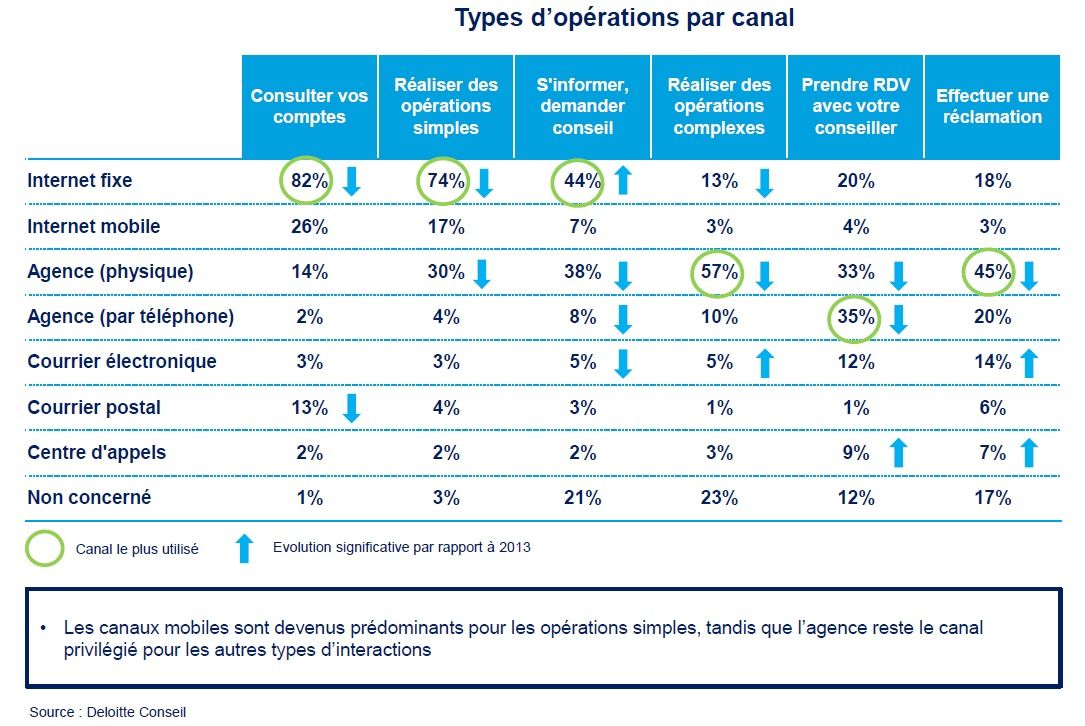

La plupart des clients utilisent les services en ligne de leur banque, depuis l'Internet fixe ou mobile. Pourtant, comme pour l'assurance et le e-commerce, le parcours client est encore hybride et est un mixte des différents canaux de distribution : le client passe d'un canal à l'autre en fonction des opérations à réaliser. L'enquête 2014 de Deloitte le résume assez bien : les canaux Internet et mobiles sont utilisés pour les opérations simples (consultation de compte, virement, commandes de chèque), tandis que l'agence reste privilégiée pour les autres types d'interactions (réclamation, rendez-vous avec son conseiller, simulation de crédit, etc.). Mais les usages évoluent à la vitesse grand "V". L'enquête de 2015 montre en effet que même pour des opérations complexes, l'agence perd du terrain même si elle reste prédominante : le nombre de clients se rendant à l'agence pour des démarches telles que la souscription d'un contrat d'assurance-vie ou la passation d'un ordre de Bourse continue à baisser.

Pour s'adapter à ces nouveaux usages, les banques françaises ont développé de nouvelles banques 100% en ligne, voire 100% mobile, dont les coûts de gestion sont théoriquement bien moindres et qui permettent d’attirer une clientèle plus jeune. La BNP Paribas a ainsi créé Hello bank! en 2014, une banque mobile, en complément de sa banque en ligne, la "Net Agence". La Société Générale a acquis en juin dernier l’intégralité de Boursorama Banque (banque 100% en ligne), tandis que LCL a lancé e-LCL, banque 100% en ligne. Le Crédit Mutuel-CIC - entité regroupant les fédérations du Centre Est Europe, du Sud-Est, d’Ile-de-France, de Savoie-Mont Blanc, du Midi Atlantique, de Normandie, de Méditerranée, de Loire-Atlantique Centre-Ouest, du Centre, du Dauphiné-Vivarais et d'Anjou et le CIC, une filiale allemande (Targobank) - mise sur Monabanq, banque en ligne créée en 1999, alors que le Crédit Mutuel Arkea - entité qui réunit les fédérations de Bretagne, du Sud-Ouest et du Massif Central - a mis la main sur Fortuneo Banque, entité créée en 2006 (le monde du mutualisme est parfois compliqué). Le Crédit Agricole a quant à lui lancé BforBank le 1er octobre 2009, 9 ans après l'entrée d'ING Direct sur le marché français (ING Direct est le n°1 de la banque en ligne en France et 2eme entrant après Monabanq) et Axa, dernier entrant, a lancé Soon, sa banque 100% mobile en 2014.

Pour s'adapter à ces nouveaux usages, les banques françaises ont développé de nouvelles banques 100% en ligne, voire 100% mobile, dont les coûts de gestion sont théoriquement bien moindres et qui permettent d’attirer une clientèle plus jeune. La BNP Paribas a ainsi créé Hello bank! en 2014, une banque mobile, en complément de sa banque en ligne, la "Net Agence". La Société Générale a acquis en juin dernier l’intégralité de Boursorama Banque (banque 100% en ligne), tandis que LCL a lancé e-LCL, banque 100% en ligne. Le Crédit Mutuel-CIC - entité regroupant les fédérations du Centre Est Europe, du Sud-Est, d’Ile-de-France, de Savoie-Mont Blanc, du Midi Atlantique, de Normandie, de Méditerranée, de Loire-Atlantique Centre-Ouest, du Centre, du Dauphiné-Vivarais et d'Anjou et le CIC, une filiale allemande (Targobank) - mise sur Monabanq, banque en ligne créée en 1999, alors que le Crédit Mutuel Arkea - entité qui réunit les fédérations de Bretagne, du Sud-Ouest et du Massif Central - a mis la main sur Fortuneo Banque, entité créée en 2006 (le monde du mutualisme est parfois compliqué). Le Crédit Agricole a quant à lui lancé BforBank le 1er octobre 2009, 9 ans après l'entrée d'ING Direct sur le marché français (ING Direct est le n°1 de la banque en ligne en France et 2eme entrant après Monabanq) et Axa, dernier entrant, a lancé Soon, sa banque 100% mobile en 2014.

Les banques 100% en ligne ne doivent pas être assimilées aux services en ligne des banques classiques. Elles ne viennent pas en complément de l'agence : elles n'ont tout simplement pas d'agences. Toutes les activités bancaires se font donc à distance par plusieurs canaux de liaison, Internet fixe ou mobile, téléphone, webcam, e-mail ou courrier papier. Les contrats peuvent être signés en ligne grâce à la signature électronique ou peuvent faire l'objet d'une souscription papier par l'intermédiaire d'un contrat fourni sous forme de fichier PDF qui doit être imprimé puis envoyé par courrier avec les pièces justificatives. Le dépôt des chèques peut être effectué en ligne grâce à des bordereaux numériques. Les chèques papier sont endossés puis retournés par courrier à la banque en ligne. Les retraits d'espèces sont effectués au moyen d'une Carte Bancaire (Carte Bleue, Visa, Mastercard) depuis n'importe quel automate bancaire de retrait (GAB/DAB). Enfin, les conseillers bancaires à distance sont joignables par téléphone, mail, webcam, chat ou courrier postale. Les banques en ligne ayant généralement des horaires d'ouverture plus amples en journée et le week-end en comparaison des agences bancaires, et ont des frais théoriquement inférieurs aux banques classiques.

Quant aux banques 100% mobile, elles n'ont même pas de site Web mais ne sont consultables que depuis un smartphone ou un mobile. Car le trafic se fait depuis ces terminaux. Elles fonctionnent sinon sur le même modèle que la banque en ligne.

Les "pure players" apparus sur le marché en 1994 ont fait faillite, ou ont été racheté (cf. "Banque Directe", filiale de la compagnie bancaire, ZeBank devenue Egg, BipBop). Mais la banque en ligne a aujourd'hui trouvé son marché. D'après un sondage du cabinet de conseil Simon-Kucher réalisé auprès d'un échantillon de 1 000 personnes en 2014, quelques 7% des Français étaient déjà clients d'une banque à ligne et ils étaient 15% au total à envisager de le devenir (19% chez les 25-54 ans). Une étude de 2015 du cabinet "Bain & Company" le confirme : sur les trois dernières années, les banques en ligne ont gagné 6% de clients par an en moyenne. L'arrivée de la 4G sur les mobiles, qui permet une consultation plus facile des services bancaires, a probablement encouragé les Français à faire le saut. La crise financière, la crise de la dette, la crise tout court est aussi passée par là ; les clients recherchent des banques avec des frais bancaires moins élevés. Et des services simplifiés plus lisibles.

Des chiffres qui cachent une certaine prudence des français : Boursorama, la banque en ligne filiale de la Société Générale, se vantait d'une augmentation massive de ses clients. Entre 12 000 et 13000 nouvelles ouvertures de compte par mois constatées en 2014 alors qu'il y a deux ans, la banque atteignait seulement les 2 000. Mais seulement 40% des clients de Boursorama l'utilisaient comme banque principale.

Ce retard à l'allumage provient en grande partie des freins au changement de banque : «Alors qu'en moyenne près de 25% des clients bancaires se disent insatisfaits de leur banque, seuls 3% des clients changent de banque chaque année», a expliqué l'association UFC-Que Choisir dans une récente étude. «C'est trois fois moins que la moyenne européenne, et cinq fois moins que la mobilité française en téléphonie ou en assurance.». Le crédit (personnel ou immobilier), l'assurance-vie et les comptes d'épargne règlementée favorisent la sédentarité du client et de son compte courant bancaire qui sert de pivot aux opérations de prélèvement et de virement». En moyenne les clients particuliers des banques détiennent chacun environ 7 produits bancaires (y compris le compte principal), dont le fonctionnement est souvent attaché au compte bancaire. Autre obstacle pointé par l'UFC-Que Choisir, «la lourdeur du changement des domiciliations (virements, prélèvements) et les risques d'erreurs lors de ce changement, avec les chèques, en particulier".

Tout cela devrait donc laisser le temps aux banques traditionnelles de trouver un nouveau modèle pour leurs agences. En résolvant un paradoxe : si les français désertent les agences, ils sont encore 55% à souhaiter toujours disposer d’un conseiller attitré (selon un sondage BVA réalisé en 2014 pour la fédération bancaire française) et 57% selon Deloitte souhaitent que leur conseiller ait de solides compétences techniques.

Vers des agences moins nombreuses mais plus spécialisées ?

Puisque le client peut effectuer ses opérations courantes lui-même en ligne, les agences doivent désormais offrir d'autres services pour que les clients aient des raisons de s’y rendre. Surtout que la concurrence des banques en ligne s'intensifie, comme on vient de le voir, et que de nouveaux acteurs entrent sur le marché : les fintechs (start-ups utilisant des technologies innovantes liées au secteur financier) proposent à leur tour des services financiers concurrents en se différenciant fortement par leurs modèles opérationnels, technologiques ou économiques disruptifs.

La Société Générale mise désormais sur des agences plus grandes avec des conseillers de plus en plus experts : une agence pourrait se spécialiser dans les opérations immobilières, une autre se consacrer aux produits d’épargne, etc. Un mouvement qu’empruntent également la BNP Paribas ou encore LCL. Quant aux opérations les plus courantes, elles pourraient encore se faire en agences, mais pas au guichet : le CIC, la Société générale et la BNP Paribas installent des centres automatisés avec des effectifs humains réduits au minimum. Les agences s'automatisent en effet de plus en plus, avec des GAB, ces automates qui vous permettent de retirer des billets ou de la monnaie, de verser des espèces, de consulter votre compte ou de commander un chéquier, des scanners de chèques et des coffres de nuit.

La Société Générale mise désormais sur des agences plus grandes avec des conseillers de plus en plus experts : une agence pourrait se spécialiser dans les opérations immobilières, une autre se consacrer aux produits d’épargne, etc. Un mouvement qu’empruntent également la BNP Paribas ou encore LCL. Quant aux opérations les plus courantes, elles pourraient encore se faire en agences, mais pas au guichet : le CIC, la Société générale et la BNP Paribas installent des centres automatisés avec des effectifs humains réduits au minimum. Les agences s'automatisent en effet de plus en plus, avec des GAB, ces automates qui vous permettent de retirer des billets ou de la monnaie, de verser des espèces, de consulter votre compte ou de commander un chéquier, des scanners de chèques et des coffres de nuit.

L'automatisation ne touche malheureusement pas que les agences, mais aussi les centres d'appel et les conseillers. Ainsi, grâce au machine learning et à l'intelligence artificielle, ce seront des robots, comme IBM Watson qui discuteront avec vous, ou comme Betterment qui vous conseilleront, dans vos investissements : spécifiez votre tolérance au risque et vos préférences d’investissement, le robot conseiller s'occupe de la gestion des placements et le rééquilibrage du portefeuille.

Ce constat, certes encore un peu avant-gardiste, peut être dérangeant pour les banques. Si ces dernières réfléchissent à spécialiser leurs agences dans des conseils à fortes valeurs ajoutées, comme la gestion patrimoniale, le conseil dédié à l'immobilier, à la banque privée ou au crédit à la consommation, il y a de bonnes chances pour que ces services soient aussi réalisés par des banques mobiles. Et le français n'est pas à un paradoxe près. S'il réclame un conseiller, et plus d'expertise, il ne vient en agence pour du conseil que dans 14 % des cas ! Dans l'immense majorité des cas, il vient traiter d'une réclamation ou pour de la gestion courante.

La réponse qui semblait évidente l'est du coup beaucoup moins : l'agence avec des conseillers experts ne peut être qu'une des réponses aux besoins des clients. Il est en fait probable que les agences bancaires prennent plusieurs formes différentes : agence bureau pour les rendez-vous, agence complètement automatisée, agence show-room, agence généraliste s'appuyant sur des spécialistes en central, etc.

Les banques expérimentent différents modèles d'agence

Pour définir les modèles les plus adaptés aux besoins de demain, les banques se cherchent, expérimentent et communiquent énormément sur ces ballons d'essai. On trouve ainsi quelques exemples significatifs :

Entre octobre 2011 et avril 2012, la BNP Paribas ouvrait six agences « nouvelle génération », avec la possibilité d'avoir des entretiens en côte-à-côte entre les clients qui le souhaitent et leur conseiller, et face à l'écran, grâce à un mobilier spécialement adapté, la possibilité, au cours d'un rendez-vous avec un conseiller de l'agence, de faire appel en visioconférence à un expert BNP Paribas, spécialiste des sujets d'épargne ou de crédit, une zone d'attente active autour d'une « table d'hôtes ou bar à tablettes» équipée de bornes tactiles ou d'iPad présentant l'offre de la banque, un accès à la presse ou encore des jeux pour les enfants, et un espace "Libre-Service" équipé d'automates permettant de réaliser toutes les opérations courantes, sur des plages horaires élargies (retrait, dépôts d'espèces et de chèques, accès aux comptes). Le réseau BNP Paribas devrait ainsi être divisé à terme en trois catégories d’agences : les « agences express », avec automates ou tablettes pour les opérations du quotidien ; les agences « conseil » avec des conseillers généralistes et la possibilité de réaliser une visioconférence avec un expert ; et les agences « projets » avec des conseillers spécialisés.

Début 2014, le Crédit Mutuel Arkéa "réinventait l’expérience client" avec de nouvelles agences "digitales". Là encore, la nouvelle agence fait la part belle aux supports tactiles avec un bar à tablettes, aux grands espaces avec des écrans muraux, au libre-service, et propose même un coin café et une zone pour consulter la presse locale pour plus de convivialité. Avec un positionnement clairement moins commercial et plus dans l'accompagnement. Fin 2014, le Crédit Mutuel Arkéa lançait également le déploiement de la technologie iBeacon dans son réseau d’agences, par l'intermédiaire d'une nouvelle application maison. Le Beacon est une technologie de géolocalisation beaucoup plus précise que le GPS. Elle permet de localiser précisément la position du client dans l'agence et d'envoyer des informations sur son identification par bluetooth. Les clients ayant téléchargé l’application pouvaient donc être « identifiés dès leur entrée dans l’agence » et leur conseiller prévenu de leur arrivée.

Le 7 avril 2015, la Caisse d'Epargne Lorraine Champagne-Ardenne a dévoilé « une agence 100% innovante » à Metz. 300 m2 répartis sur deux niveaux, un écran interactif sans contact à l’extérieur de l'agence (sans contact car l'écran se trouve derrière la vitrine, pas devant), une borne d’accueil tactile pour signaler son arrivée directement aux conseillers, un « bar à tablettes », un hot-spot wifi, une table tactile (Microsoft Surface) dans le bureau du conseiller (avec de la documentation, mais aussi de l'aide sur les services en ligne, et des jeux pour enfants), la possibilité d'avoir des entretiens en côte-à-côte. A noter un espace de travail partagé pour les conseillers qui n'ont plus de bureau attitré. Cela leur permet de travailler en mode collaboratif, quand ils ne sont pas en rendez-vous clientèle. Tout ceci ressemble furieusement aux agences innovantes de la BNP. D'ailleurs la Caisse d'Epargne a également annoncé, à l'instar du Crédit Mutuel le prochain déploiement de iBeacon.

L'agence bancaire de demain sera multiforme et multicanale

A travers ces expérimentations, on trouve ainsi plusieurs modèles d'agence possibles :

-

Les agences sans employés, entièrement automatisées, avec Guichets Automatiques Bancaires, Scanners de chèques, Bornes automatiques, organisées en espaces libre-service.

-

Les agences moyennes regroupant des conseillers généralistes qui pourront recourir à l’expertise des grandes agences via la visioconférence notamment.

-

Les grandes agences conçues comme « des pôles d’expertise », regroupant des conseillers généralistes et des conseillers spécialistes. Les conseillers sont alors organisés par produit, comme dans un grand magasin de bricolage où vous trouvez le vendeur spécialiste de l'électricité, de la peinture, etc.

-

Les agences bureaux (ou agence à l'étage) qui ne proposeront que des rendez-vous, typiquement pour la clientèle professionnelle.

L'aménagement des agences change aussi. Car l'agence bancaire est une boutique comme les autres. Elle se structure donc en espaces dédiés :

-

Des espaces pensés comme un café : un endroit convivial favorisant les échanges avec café, presse, jeux pour enfants, etc.

-

Des espaces axé sur le tout numérique (avec probablement un équilibre à trouver entre le numérique et l'humain, car il y a parfois overdose d'écrans) : des bars à tablettes, des bornes interactives, des murs d'écrans interactifs ou pas, extérieurs ou intérieurs, des tables tactiles, des écrans pour les entretiens en côte-à-côte. Tout ce dispositif venant en appui au conseiller.

Enfin, l'organisation des agences changent également :

-

Un conseiller n'est plus forcément attaché à une agence donnée, mais peut partager son temps entre plusieurs agences.

-

L'agence n'est plus forcément ouverte 5 jours sur 7, du mardi au samedi, mais peut fermer certains jours.

Les banques en ligne viendraient en complément du réseau des agences des banques traditionnelles; Leurs services pourraient être consultés au sein de l'agence, avec l'assistance ou pas d'un conseiller. On retrouverait ainsi le mixte canal numérique / canal physique que les boutiques se plaisent à recréer avec les offres de "click and collect". On pourrait ainsi imaginer commander des devises sur Internet et les retirer en agence, comme le propose déjà ICE. Car pour faire (re)venir le client en agence, il n'y a pas de mystère. Il faut coupler les services numériques, mobiles, et l'agence. Et cela commence déjà par les moyens de paiement. Car rappelons une évidence, c'est au moment de passer à la caisse qu'on a le plus besoin de sa banque.

Relativisons : la nécessaire transformation du réseau de distribution des banques n'est que la partie émergée de l'iceberg : les banques devront affronter d'autres changements majeurs dans les prochaines années. Concurrence des banques en lignes, des "fintech", révolution des moyens de paiement, nouveaux services disruptifs, poids du réglementaire, les sujets ne manquent pas.

Les impacts de la transformation digitale sur la DSI

Les impacts de la transformation digitale sur la DSI : Première partie

La transformation numérique, qu'on appelle aussi digitale (anglicisme issu de "digit", chiffre, nombre, qu'il ne faut pas confondre avec digital, du latin digitalis, de digitus, doigt), sans doute parce que parler de numérisation, cela fait penser à une simple dématérialisation de document par scanner, alors qu'il ne s'agit pas que de cela bien sûr, la transformation numérique ou digitale disais-je donc, décrit les profonds changements de notre société provoqués par l'introduction massive de nouvelles technologies numériques dans tous les domaines de notre vie, doublée d'une révolution des usages.

Le client d'aujourd'hui, et principalement celui de la génération Y ou Z, est devenu mobile, utilise son smartphone pour ses achats, ses voyages, ses loisirs ; Il est "social", il communique beaucoup sur les réseaux sociaux ; Il est hyper connecté : il a vécu la consumérisation de l'électronique s'est essayé au BYOD.

Tous ces changements ont induit de nouveaux rapports entre l'informatique et ses utilisateurs, entre l'entreprise et sa DSI. Même si rien n'est encore écrit, analysons ce qui pousse la DSI à changer et à s'adapter pour mieux servir et innover. Mais regardons d'abord la transformation numérique alliant innovations numériques et révolution des usages, avant de détailler celles qui impactent la DSI et les évolutions possibles.

1 - Innovations technologiques...

Je me suis souvent amusé avec mes enfants à jouer au paradoxe de l’œuf et de la poule. Qui de l'œuf ou de la poule est arrivé le premier ? Question qui n'a pas de réponse absolue. Et je peux me poser la même question au sujet de l'innovation et des usages. Est-ce l'innovation technologique qui pousse les usages à changer ou est-ce l'usage et les nouveaux besoins qui poussent les entreprises à innover ?

En fait, tout dépend probablement de la nature de l'innovation et de l'importance du changement qu'elle induit. Néanmoins, nous pouvons être sûr d'une chose, c'est que nous vivons aujourd'hui une période où les innovations se succèdent à un rythme important et qu'elles sont pour beaucoup disruptives (voir mon billet sur les 10 technologies de rupture), c'est à dire qu'elles transforment profondément nos usages et nos sociétés.

L'innovation est couramment définie comme une invention qui a rencontré un marché. L'innovation technologique peut donc se définir comme la création ou l'invention d'un nouveau produit ou service, ou d'un nouveau procédé de fabrication. Rien de neuf, je ne fais que reprendre la définition de l'innovation technologique, communément employée dans la littérature universitaire.

-

Ainsi donc, on parlera d’innovation de produits ou de services quand elle consiste à créer ou améliorer un produit ou une prestation de services. La création porte en elle une importance de changement beaucoup plus forte que l'amélioration, ce qui fait que certains ne considèrent pas l'amélioration comme une réelle innovation mais c'est pourtant bien le cas. A titre d'exemples, on peut citer :

-

Le feu ; bon d'accord, c'était il y a plus de 450 000 ans...mais sans feu, pas de civilisation.

-

Le papier ; sans le papier, pas d'écriture et pas de transmission du savoir...Même si ironie du sort, le numérique doit "ubériser" cette invention avec celle de l'imprimerie...

-

La vaccination et l'antisepsie ; si elles ne vous ont pas changé la vie, elles vous l'ont sauvée !

-

La roue, qui a permis d'autres inventions comme la bicyclette, la voiture...

-

Le circuit intégré, qui a rendu possible la miniaturisation, telle que nous la connaissons maintenant, avec le téléphone, la télévision...

-

Les logiciels de traitement de texte, Internet, etc. etc.

-

On parlera plutôt d'innovation de procédé (ou de processus) quand elle correspond à la mise en œuvre de nouvelles techniques ou l’amélioration des techniques permettant la production ou la distribution de produits ou la réalisation de prestations de services qui existent déjà (difficile de parler d'innovation de produits dans ces cas là). Donnons quelques exemples pour mieux cerner la différence avec les produits et services :

-

La culture hors-sol (oui je sais ce n'est pas bon)

-

La Conception Assistée par Ordinateur (C.A.O) ou mieux encore la Gestion de la Production Assistée par Ordinateur (G.P.A.O).

-

Le système de traçabilité des marchandises par code à barres, ou plus récemment par puces RFID

-

La vente en ligne ou encore le "Click & Collect" ( appelé aussi Web to store)

-

La livraison par drone, etc. etc.

-

L’innovation technologique répond à un besoin du marché (il s'agit dans ce cas plutôt d'une amélioration) ou plus généralement anticipe des besoins futurs (nous sommes alors plutôt dans la création). Ainsi, le téléphone mobile a plutôt créé le marché qu'il n'a répondu à un besoin clairement exprimé. Et a complètement bouleversé le marché de la téléphonie et nos usages. On distinguera donc 4 niveaux d'importance dans les changements. 2 très connus, qui correspondent aux innovations de rupture et incrémentales, et deux, moins connus qui correspondent à des innovations de combinaisons ou de transposition :

-

La rupture : on parle d'innovation disruptive ; L’innovation de rupture introduit un changement majeur qui permet de créer de nouveaux marchés ou de modifier nos comportements de consommation voire la société. Elle vous donne un avantage compétitif majeur par rapport à la concurrence mais en contrepartie, le niveau de risque et d’incertitude est très élevé voire parfois total. Le marché est souvent à créer. Nous connaissons tous des innovations de rupture :

-

La voiture, qui a révolutionné le transport, le réfrigérateur ou la machine à laver le linge...

-

Le courrier électronique qui a modifié nos façons de communiquer et transformé les métiers des postiers

-

La carte bancaire, en remplacement du chèque, du liquide et des devises

ou encore plus récemment

-

Uber, qui a révolutionné le marché de la Voiture de Tourisme avec Chauffeur (VTC), pour ne pas citer son service jugé illégal UberPop, BlaBlaCar, qui a modernisé le covoiturage et répondu à un besoin de transport à bas prix, AirBnB, qui taille des croupières aux hôteliers avec une offre radicalement différente de celle des hôtels traditionnels.

-

-

La combinaison : l'innovation résulte d'une combinaison de produits ou services déjà existants. L'importance du changement induit par ces combinaisons peut varier selon leur nombre mais est généralement importante. Les produits les plus connus :

-

L'iPhone, qui n'est pas une innovation résultante d'une invention particulière mais l'intégration dans un seul et unique appareil d’un écran tactile capacitif multipoint , d'un appareil photo/caméra, d'un système de géolocalisation intégré ainsi que d'un logiciel de cartographie, d'un iPod, et surtout d'un navigateur Internet permettant d’être connecté à tous les services Internet et d’un client de messagerie, sans compter les fonctions élémentaires telles que le téléphone, les SMS et les MMS. L'iPhone représente une innovation utilisant une dizaine de combinaisons.

-

Le Kite Surf, sport très à la mode en ce moment, et qui est la combinaison d'une planche de surf et d'une voile de parapente, deux sports pré-existants par ailleurs.

-

L'amélioration : on parle d'innovation incrémentale ou cumulative, car l'innovation ne crée pas un nouveau produit ou service mais y apporte une amélioration sensible. Le changement est généralement mineur en termes d'impacts. Citons :

-

Les évolutions successives des réseaux de communication mobiles, 2G, 3G, 4G et bientôt 5G. La 2G a introduit le numérique dans les communications, la 3G a permis des débits plus importants et les transmissions de données (en 2G, le mobile devait être utilisé comme un modem). La 4G apporte des débits 3 fois plus rapide qu’en 3G. La différence avec le Wifi s'estompe.

-

Les améliorations apportées aux télévisions à écran cathodique, de l'écran LCD et plasma en définition HD puis Full HD, puis à LED en 3D aux écrans 3D UHD et maintenant OLED UHD 3D. On peut aussi citer les iPhones 1, 2, 3, 4, 5, 6...et autres iPad...

-

La locomotive à vapeur, puis à diesel, puis à électricité, puis à suspension magnétique

-

-

La transposition : il s'agit d'une innovation résultante de la copie et/ou l'adaptation d'une précédente innovation, d’un secteur vers un autre secteur. C'est une notion un peu floue mais les exemples sont parlants :

-

L'autolib' est la transposition à l'auto de vélib', eux-mêmes inspirés des vélos jaunes de La Rochelle.

-

Les "drive" des hypermarchés, directement inspirés des drives des fastfoods (ils ont d'ailleurs utilisé le même anglicisme).

Cette classification des innovations, cela peu paraître de l'ordre du détail, mais elle a deux grands avantages pour moi. Elle permet d'une part de ne pas passer à côté d'une innovation en donnant des critères objectifs : Microsoft a longtemps raillé l'iPhone, rappelez-vous de l'interview de Steve Balmer en 2007 : "500 dollars? Fully subsidized? With a plan? I said that is the most expensive phone in the world. And it doesn't appeal to business customers because it doesn't have a keyboard. Which makes it not a very good email machine". Et bien, il n'aurait pas du...Quand j'ai vu et touché l'iphone pour la première fois, j'ai su que cela allait être une tuerie. Cette classification permet d'autre part de mieux cerner un des sujets de mon article, les innovations disruptives et incrémentales.

2 - ...Et révolution des usages

L'innovation d’usage est le changement introduit dans la manière d’utiliser le produit ou de consommer le service. Pour comprendre comment les usages changent, il faut d'abord comprendre les nouveaux utilisateurs. Notamment ceux qu'on englobe dans les appellations "Générations Y et Z".

Inventées par des sociologues outre-Atlantique, ces typologies sont souvent caricaturées par les médias. Elles permettent néanmoins d'analyser les changements que nous vivons aujourd'hui. On distingue la génération X, née entre 1960 et 1970, c’est-à-dire les quinquagénaires; Les "Y" sont nés quant à eux dans les années 1980 et 1990, aujourd’hui quadras. C’est cette même génération que l’on qualifie de «digital native» car née avec Internet. Enfin, on parle de la génération Z, née à partir de 1995 avec le Web 2.0. Communication paroxystique, mobilité incessante, information instantanée sont dans l’ADN des "Y". On insiste sur leur souhait d’avoir un plus grand équilibre entre vie privée et vie professionnelle. Ils sont considérés comme à la fois individualistes et coopératifs au travail. Ils apportent avec eux, au sein de l’entreprise, un usage précoce du numérique acquis à la maison. Par comparaison, la génération suivante, la Z, est hyper-connectée mais plutôt «Web 2.0 » (orientée réseaux sociaux), avec un goût pour le ludique qui se retrouve aussi au travail. Ils seraient encore plus « zappeurs » que leurs aînés, les Y. Habitués à se débrouiller seuls, les jeunes ont un rapport étroit et inné aux TIC et une culture de l’instantanéité (selon une enquête de l’Observatoire des Usages du Numérique, 48% des personnes répondent dans la minute à un SMS et 30% dans l’heure. En retour, 28% s’attendent à une réponse dans la minute et 38% dans l’heure). Ce besoin d’immédiateté est devenu une constante : ils peuvent ainsi passer d’un site marchand à l’autre si le premier est jugé trop lent. Plus instruits et diplômés que leurs aînés au même âge, ils privilégient l’apprentissage par l’action, le développement personnel et la quête de sens. Rétifs aux contraintes, mais dotés d’un esprit communautaire, ils jonglent avec les réseaux sociaux, les portables et l’informatique de manière intuitive et innée. La Génération Z attache une grande importance aux communautés virtuelles, aux réseaux sociaux, et est friande des avis de ses pairs (ranking des sites Web). Elle accorde d’ailleurs plus d’importance à ces derniers qu’aux propres réponses qu’elle peut obtenir du site de la marque ou de l’entreprise.

Cette analyse sociologique permet d'identifier 4 grandes tendances dans les usages d'aujourd'hui :

2.1 Le partage et le collaboratif : Bien sûr le partage et le collaboratif doivent leur essor aux technologies qui permettent la mise en relation des individus mais il s'agit aussi d'un mouvement de fond plus important que le simple covoiturage illustré par la réussite de BlaBlaCar. Car les sociétés de partage fleurissent : Drivy ou Koolicar pour l'autopartage, "couchsurfing", entreprise assurant la mise en relation de personnes proposant ou cherchant un service d'hébergement temporaire et gratuit. Il existe d'autres mouvements comme le coworking : destiné initialement aux indépendants, le coworking permet de partager des locaux, des ressources ou services (lignes téléphoniques, accès Internet, assistance informatique, gestion du courrier, etc…) mais aussi et surtout des compétences et des projets. Citons encore le crowdfunding (financement participatif en bon français) qui permet aux internautes d'apporter l’argent nécessaire à la réalisation du projet en contre-partie d'une rémunération en nature ou en argent. Ou encore la cocréation qui consiste, pour une entreprise, à développer des produits ou services en collaboration active avec ses clients et ce, de façon durable. Le meilleur exemple est celui de Lego, avec son site "ideas", qui incite les fans de la marque à soumettre leurs idées de kit Lego ou à aimer et supporter les idées des autres. Les meilleures idées sont effectivement mises sur le marché. Cette initiative fait partie de ses nombreuses initiatives dans le numérique, des jeux vidéos au film en passant par Lego ReBrick, communauté pour les fans de la marque.

2.1 Le partage et le collaboratif : Bien sûr le partage et le collaboratif doivent leur essor aux technologies qui permettent la mise en relation des individus mais il s'agit aussi d'un mouvement de fond plus important que le simple covoiturage illustré par la réussite de BlaBlaCar. Car les sociétés de partage fleurissent : Drivy ou Koolicar pour l'autopartage, "couchsurfing", entreprise assurant la mise en relation de personnes proposant ou cherchant un service d'hébergement temporaire et gratuit. Il existe d'autres mouvements comme le coworking : destiné initialement aux indépendants, le coworking permet de partager des locaux, des ressources ou services (lignes téléphoniques, accès Internet, assistance informatique, gestion du courrier, etc…) mais aussi et surtout des compétences et des projets. Citons encore le crowdfunding (financement participatif en bon français) qui permet aux internautes d'apporter l’argent nécessaire à la réalisation du projet en contre-partie d'une rémunération en nature ou en argent. Ou encore la cocréation qui consiste, pour une entreprise, à développer des produits ou services en collaboration active avec ses clients et ce, de façon durable. Le meilleur exemple est celui de Lego, avec son site "ideas", qui incite les fans de la marque à soumettre leurs idées de kit Lego ou à aimer et supporter les idées des autres. Les meilleures idées sont effectivement mises sur le marché. Cette initiative fait partie de ses nombreuses initiatives dans le numérique, des jeux vidéos au film en passant par Lego ReBrick, communauté pour les fans de la marque.

2.2 L'usage et la fonctionnalité : Nous sommes passés d’une économie de la propriété à une économie de l’usage (ou de la fonctionnalité) : on ne vend plus un produit mais un usage. L’exemple le plus connu est celui de la musique en ligne, de Deezer à Qobuz en passant par spotify. Les ventes de musique sous forme de CD se sont écroulées, compensées pour partie par la musique dématérialisée (iTunes ou Amazon en sont de bons exemples, mais le téléchargement légal de mp3 est toujours basé sur le modèle de la possession), mais surtout remplacées par les services de streaming : on écoute mais on ne possède plus. Et plus encore, on partage en créant des playlists qu’on transfère ou qu’on échange (cf. l'économie de partage supra). Les offres de Vélib' et Autolib' dérivent également de ce mouvement.

2.2 L'usage et la fonctionnalité : Nous sommes passés d’une économie de la propriété à une économie de l’usage (ou de la fonctionnalité) : on ne vend plus un produit mais un usage. L’exemple le plus connu est celui de la musique en ligne, de Deezer à Qobuz en passant par spotify. Les ventes de musique sous forme de CD se sont écroulées, compensées pour partie par la musique dématérialisée (iTunes ou Amazon en sont de bons exemples, mais le téléchargement légal de mp3 est toujours basé sur le modèle de la possession), mais surtout remplacées par les services de streaming : on écoute mais on ne possède plus. Et plus encore, on partage en créant des playlists qu’on transfère ou qu’on échange (cf. l'économie de partage supra). Les offres de Vélib' et Autolib' dérivent également de ce mouvement.

2.3 La mobilité et l'instantanéité : Les internautes se font mobinautes et impatients. Cela parait simple à dire mais les impacts sont énormes ; Cela signifie d'une part que l'utilisateur utilise de plus en plus son smartphone et de moins en moins son PC ou sa tablette (ce qui explique d'ailleurs l'attrition de ces deux marchés). Il faut donc développer en conséquence des services. Il faut d'abord que les serveurs soient "ubiquitaires", c'est à dire accessibles n'importe quand, de partout, de n'importe quel terminal. C'est le concept ATAWAD (Any Time, Any Where, Any Device). Car il faut pouvoir répondre tout de suite et à toute heure, et sur n'importe quel canal (ou presque). Il faut ensuite adapter les services aux possibilités qu'offrent les smartphones, notamment la géolocalisation. C'est ainsi que les e-services deviennent les m-services. On voit donc apparaître des applications de guidage, communautaires de préférence (Waze, iCoyote), de services VTC comme Uber qui géolocalise le client et le conducteur pour les mettre en relation, des applications de paiements, de loisirs (tripadvisor, allociné vous proposent leurs adresses à proximité) ou de santé (Runtastic qui allie GPS, application mobile, objets connectés et réseaux sociaux).

2.4 Les réseaux sociaux et les communautés : Les réseaux sociaux sont des outils qui permettent de publier de l'information, de la partager avec votre communauté d'amis ou de "followers", de discuter et communiquer (chaque outil dispose de sa messagerie classique et instantanée) et de réseauter en vous créant de nouveaux contacts. Si les réseaux sociaux sont si importants pour l'économie, c'est qu'ils pèsent lourds dans la confiance qu'on accordera à un site marchand ou dans l'attachement à une marque ; 14% des consommateurs que nous sommes font confiance à la publicité (la notoriété cela joue), mais 70% font confiance dans les avis que laissent les autres consommateurs et surtout 90% font confiance dans les avis de leurs amis.

Les entreprises l'ont bien compris. C'est pourquoi vous pouvez noter votre chauffeur ou votre passager sur BlaBlaCar, votre hébergeur sur AirBnB, votre restaurant ou hôtel préféré sur TripAdvisor, partager votre parcours santé et vos progrès sur Facebook grâce à Runtastic, etc. Et il n'est pas un site d'information qui ne vous propose de dire "j'aime", de "twitter", ou poster sur LinkedIn, voire les 3 à la fois si vous avez liés vos comptes.

Vous l'avez compris, cette transformation numérique est à l'origine de nombreux changements dans notre vie quotidienne, dans nos habitudes de travail et dans l'organisation des entreprises. Tout ceci donc pour en arriver à cette question cruciale : En quoi la DSI est-elle impactée par ses changements et pourquoi doit-elle s'adapter ? Ceci nous amène sur la seconde partie de mon article.

Les impacts de la transformation digitale sur la DSI : Deuxième partie

3 - Les DSI face aux changements technologiques et des usages

Nous avons vu dans la première partie de cette article que le "buzz word" de cette année 2015, la transformation digitale, était une sorte de cocktail explosif entre les innovations technologiques d'une part et les révolutions des usages d'autre part. Ces changements touchent évidemment tous les secteurs et tous les métiers.

Le numérique apporte de nombreux avantages, parmi lesquels nous pouvons citer :

-

Une relation directe avec le client : il n’existe pas d’intermédiation entre l’entreprise qui produit et le consommateur.

-

Une capacité à innover : les services numériques permettent de créer de nouveaux services, sans apport important de capital et avec une vitesse de déploiement inégalée (cf. Uber).

-

Une meilleure communication entre salariés, mais aussi avec les partenaires ou fournisseurs.

-

Une meilleure performance financière, liée à une meilleure productivité.

Les entreprises doivent donc s'adapter à toute vitesse, se transformer ou mourir comme on peut le lire. Et quand on parle de transformation de l'entreprise, on parle de tous les métiers. Notamment la DSI. Dans cette seconde partie, je traite donc plus spécifiquement des aspects la transformation digitale et de ses impacts sur les DSI des entreprises.

3.1 La Consumérisation et la Prosumérisation de l'IT : Nous avons vécu un renversement des priorités ; là où l'informatique du 20eme siècle était mise au point dans les laboratoires pour des usages militaires et professionnels, puis évoluait doucement vers le marché domestique, les produits d'aujourd'hui sont créés d'abord pour le grand public avant d'être adaptés au marché professionnel. Ainsi, le blackberry a été créé pour l'entreprise, alors que l'iPhone a été conçu pour le grand (mais aisé) public. Devinez qui a gagné ? Et qui attaque désormais le marché pro avec ses iPhone mais aussi ses iPad Pro ? C'est le phénomène de consumérisation de l'informatique.

Désormais, pas besoin d'être "geek" pour avoir, qui un meilleur PC portable, qui un meilleur smartphone, qui un accès Internet plus rapide, chez soi qu'au bureau. Quoi de plus naturel que certains aient alors voulu utiliser leurs équipements personnels au sein de l'entreprise, en remplacement de terminaux jugés archaïques. C'est le phénomène de "Prosumérisation" de l'IT, qui rattrape les entreprises et les DSI sous la forme du "Bring Your Own Device" (BYOD, apporte ton propre équipement).

Pourtant, en dehors du smartphone, ce mouvement a finalement pris peu d'ampleur en France et en Europe comparés aux États-Unis et à l'Asie. En cause, la rigidité du code du travail et ses casses-têtes juridiques (l'employeur a l'obligation de fournir les moyens de travail et des obligations vis-à-vis de la collecte des données personnelles), des risques de sécurité non maîtrisés, des contraintes budgétaires (déployer une solution BYOD demande des investissements parfois non négligeables), des problèmes d'ergonomie (qui n'a pas pesté contre l'interface de Good Technologie venant remplacer celle d'Apple), ou encore de fausses promesses de baisse des coûts (subventionner et supporter une multitude de terminaux coûte cher). Notons aussi que la DSI a réagi face à la "menace" du BYOD en adaptant son offre de terminaux et en prônant le CYOD (Choose Your Own Device), offrant à l'utilisateur le choix d'un équipement dans une liste approuvée au préalable par la DSI.

Il ne faut pas pour autant négliger ce mouvement, car il impacte largement le smartphone, terminal qui est aujourd'hui privilégié pour lire ses mails et consulter son agenda, mais qui donne aussi de plus en plus accès au SI (interne ou dans le cloud), via des "apps" ou le web, grâce au responsive design et au HTML5. Le smartphone permet aussi de prendre la main à distance sur son PC via un VPN classique et des outils comme Microsoft Remote Desktop (disponible sur Android, iOS et Windows Phone), Chrome Remote Desktop ou TeamViewer. Il devient aussi poste de travail avec Continuum et les applications universelles de Windows 10. Il est donc important de bien encadrer l'usage de ces smartphones, très prisés des générations Y et Z, hyper-connectées, mais aussi des cadres dirigeants. En mettant notamment en oeuvre des solutions d'Enterprise Mobile Management, concept qui regroupe 3 grandes fonctions clés :

-

Le Mobile Device Management (MDM) qui permet de gérer les différents terminaux en poussant des paramètres ou en effaçant les données à distance en cas de perte.

-

Le Mobile Application Management (MAM), qui permet de gérer l'ensemble du cycle de vie des "apps", de leur distribution via la boutique d'applications d'entreprise (App store privé) à leur suppression. Il est aussi possible d'isoler les applications professionnelles des autres applications par cet outil.

-

Le Mobile Content Management (MCM), qui offre une consultation et une gestion sécurisées des documents de l'entreprise stockés sur des serveurs de fichiers, dans Sharepoint ou dans l'intranet de manière générale.

L'Enterprise Mobile Management n'est pas qu'une solution au problème posé par le BYOD et le CYOD. C'est aussi et avant tout une manière de répondre aux besoins de mobilité et de connectivité des collaborateurs d'aujourd'hui, en gérant efficacement les terminaux mobiles, smartphones et tablettes.

3.2 Le Cloud Computing et le Shadow IT : Le Cloud Computing peut se voir comme une évolution naturelle de l'infogérance (apparue dans les années 80) et de l'hébergement façon ASP ( apparu dans les années 90). La différence entre les deux modèles, ASP et SaaS, est d'ailleurs assez subtile : le mode ASP requiert généralement une instance dédiée de l'application pour un client donné, tandis que le mode SaaS autorise le partage de l'application par plusieurs clients différents (les données et les paramètres restant dédiés). Le mode SaaS s'appuyant par ailleurs généralement sur une offre IaaS ou PaaS, il s'adapte beaucoup plus facilement aux variations d'activités. Enfin, il s'appuie exclusivement sur les protocoles HTTP/S alors que le mode ASP autorise encore le client-serveur.