Les grandes évolutions du Système d'Information

Paris, le 14 août 2019

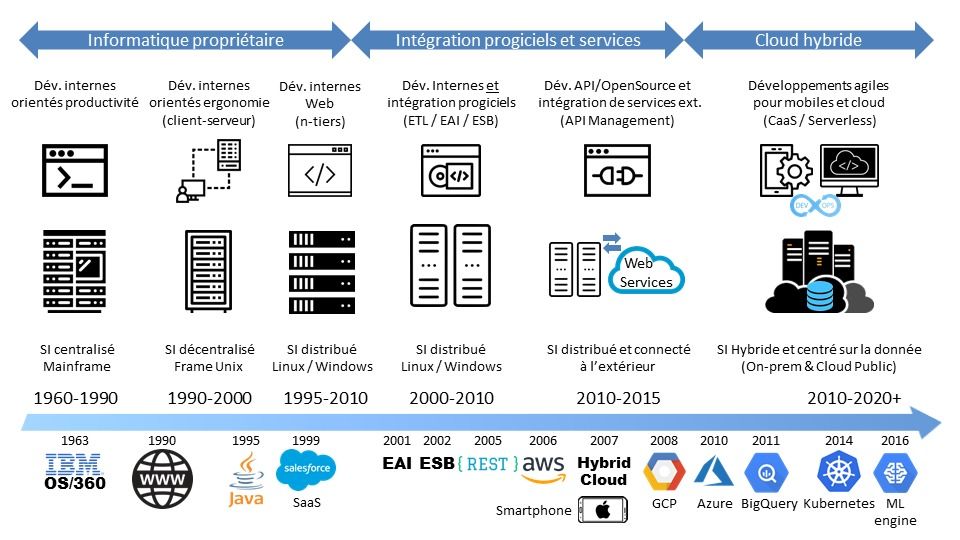

Retracer les évolutions des Système d'Information (SI) est un exercice des plus classiques. Tous les cabinets de conseil dignes de ce nom pourront vous en parler. Alors dans ce petit billet, j'ai essayé de faire différemment : j'ai fait tenir cette évolution dans une seule figure.

C'est donc forcément une analyse très macroscopique. Mais cela permet de voir d'où on vient et vers où on va en matière de SI.

Une évolution en trois phases

J'ai pour ma part identifié à ce jour trois grandes phases d'évolution du SI. A l'intérieur de chaque phase, on trouvera des évolutions structurantes bien sûr, mais qui n'ont pas fondamentalement changé la façon dont le SI fonctionnait.

1 ère phase : le SI propriétaire

Chaque entreprise, pour répondre à ses besoins, a développé ses applications et construit, brique fonctionnelle par brique fonctionnelle et serveur par serveur, son Système d'Information.

Chaque SI s'est bien sûr construit sur la base des technologies existantes de son époque. Dans les années 70, le langage de programmation Cobol et les mainframes dominaient, que ce soit ceux d'IBM, Unisys, Fujitsu, HP ou même Bull et son système d'exploitation GCOS.

Dans les années 90, les serveurs Unix ont pris le pas, et on a commencé à voir d'autres architectures apparaître : le client-serveur (que l'on a appelé rétrospectivement architecture 2-tiers) puis les architectures Web de type 3-tiers et n-tiers poussées par l'avènement d'Internet et l'apparition des langages de programmation Java et C#.

Passer des architectures monolithiques mainframe au client-serveur puis aux architectures n-tiers a demandé de très grosses évolutions technologiques. Mais cela n'a pas fondamentalement changé la façon dont on pensait le Système d'Information. Le SI était avant tout composé d'applications développées en interne avec peu d'interaction avec les autres systèmes.

2 ème phase : le SI intégré

Le passage à l'an 2000 a fait peur à tout le monde ; A tout le moins à ceux qui utilisaient l'informatique dans leur vie quotidienne. La plupart des programmes n'utilisaient alors que des dates codées sur 2 chiffres. Il a donc fallu, pour ceux qui s'en souviennent encore, engager des travaux de modernisation du SI. C'est alors que les progiciels et notamment les ERP (Enterprise Resource Planning ou Progiciel de Gestion Intégré en bon français) ont commencé à prendre une place prédominante, en remplaçant les vieux logiciels obsolètes dépassés par l'an 2000.

Il a donc fallu intégrer ces progiciels au reste du SI. Avec des applications désormais distribuées sur différents serveurs. Voire sur des serveurs virtualisés (VM). On a donc inventé des solutions comme l'EAI (Enterprise Application Integration) puis quand les interfaces Web se sont généralisées l'ESB (Enterprise Service Bus).

Et avec des interfaces Web et un réseau Internet plus fiable, on s'est aperçu qu'on pouvait faire de l'EDI (Echange de Données Informatisé) pour beaucoup moins cher et plus rapidement. On a donc commencé à intégrer les WebServices d'autres partenaires ou fournisseurs à son propre SI.

Plutôt que de développer des applications propriétaires, on a donc conçu le SI en pensant ses interfaces, ces fameuses API (Application Program Interface), permettant de communiquer tant en interne, entre le front office et le back office, qu'en externe avec d'autres SI. Avec en point central, la gestion de ces API : l'API Management, et un protocole simple : REST (REpresentational State Transfer).

3 ème phase : le SI hybride

Créer des API pour permettre à ses applications de communiquer, c'est bien. Mais généraliser les API à tout son SI, c'est encore mieux. C'est ce qui a donné naissance au Cloud et à l'automatisation d'un grand nombre d'opérations. Désormais, on ne gère plus son infrastructure par ses composants, mais par du code.

Le Cloud Public a-t-il pour autant changé notre façon de concevoir le SI ?

La réponse est non si l'on utilise le Cloud en mode IaaS (Infrastructure as a Service). Dans ce mode, l'entreprise loue des machines virtuels (VM) à son fournisseur et vient simplement installer ses applications dessus. Elle y gagne en souplesse, mais la location à long terme peut lui revenir plus cher que l'achat de serveurs en propre. Faire des économies avec le IaaS demande une gestion fine de sa capacité : il faut savoir couper les serveurs inutilisés (la nuit par exemple) et n'allouer des ressources qu'en cas de demande forte.

NB : Le mode PaaS (Platform as a Service) s'avère économiquement plus intéressant car il permet à l'entreprise de s'affranchir de toute la maintenance de la pile logiciel et du middleware, prise en charge par le fournisseur de Cloud. Mais il demande un peu de discipline car il faut naturellement que vos applications suivent les montées de version du fournisseur.

La réponse est oui si l'on commence à concevoir son SI en terme de progiciels loués en mode SaaS (Software as a Service), de micro-services, de conteneurs et d'application serverless (sans serveur). Tout en intégrant un maximum de services de son fournisseur, comme le Machine Learning, le BigData, la BlockChain, etc., et en veillant à ne pas créer trop d'adhérence entre son fournisseur et son SI.

Concevoir son SI n'est plus une histoire d'intégration de progiciels et d'API. Il s'agit plutôt d'intégrer des applications en mode SaaS avec ses propres applications, conçues en mode micro-services et Serverless. Ce terme barbare ne signifie pas que le serveur a disparu. Non, les ressources sont simplement allouées dynamiquement par le fournisseur de cloud au moment de l'exécution du code. Et vous ne payez qu'à l'usage réel (pay-as-you-go). Ce qui vous évite de réfléchir aux règles liées à l'élasticité (auto-scaling) de votre infrastructure, tout étant géré par le Cloud. Et ce n'est plus la fonction mais la donnée qui devient la brique première de votre SI.

On peut aussi coupler son code serverless à des micro-services hébergés dans des conteneurs, gérés par Kubernetes (le gestionnaire de conteneur le plus populaire loin devant Mesos ou Docker Swarm) en mode CaaS (Container as a Service).

Et comme le SI est encore en grande partie on-premise, il faut pouvoir gérer le mélange des genres, à savoir un SI hybride, hébergé dans le Cloud Public et dans des centres de traitement traditionnels. Car tout ne passera pas dans le Cloud Public quoiqu'on puisse en dire.

Les 3 phases du SI

Adapter son Home Cinema à la 4K

Paris, le 31 juillet 2019

Je vous ai parlé récemment de mon passage du Full HD à la 4K. Et des apports de cette dernière (notamment le HDR). Mais passer à la 4K n'est pas neutre quand on dispose de tout un système Home Cinema Full HD autour de sa télévision. Et mettre à jour son home cinéma revient cher, très cher. Voici donc comment j'ai ou je compte adapter mon home cinéma en plusieurs étapes.

1 - un home cinéma c'est quoi

Un home cinema, c'est un un système qui permet de retrouver un son proche de celui d'un cinéma, mais à la maison. Cela permet donc de regarder un film de son canapé et de reproduire l'ambiance sonore des salles obscures. Le son du cinéma, c'est un son "surround". Soit en bon français un son multi-canal ou encore un son ambiophonique (mais personne ne dit çà).

Une installation stéréo dispose de 2 enceintes. Une pour chaque oreille. Une installation multi-canal dispose d'au moins 5 enceintes :

-

2 enceintes frontales ; généralement on utilise des enceintes colonnes, très esthétiques mais assez encombrantes. Elles permettent la spatialisation du son, à gauche ou à droite.

-

1 enceinte centrale, positionné généralement sous la télévision, et qui permet de reproduire les dialogues du film.

-

Deux enceintes latérales ou "surround", qui permettent de reproduire les sons latéraux ou venant de l'arrière. Pour plus de réaliste, on pourra donc déployer 2 enceintes latérales et 2 enceintes arrières, pour disposer ainsi d'un système à 7 enceintes

-

A ces 5 enceintes, on rajoute généralement 1 à 2 caissons de basse pour obtenir un système 5.1 (respectivement 5.2) avec 5 canaux principaux et 1 canal LFE - Low Frequency Effect - sur lequel 10% des données numériques sont allouées. Quand on dispose de 7 enceintes, on parle de système 7.1. On peut ainsi monter jusqu'à 9 enceintes...

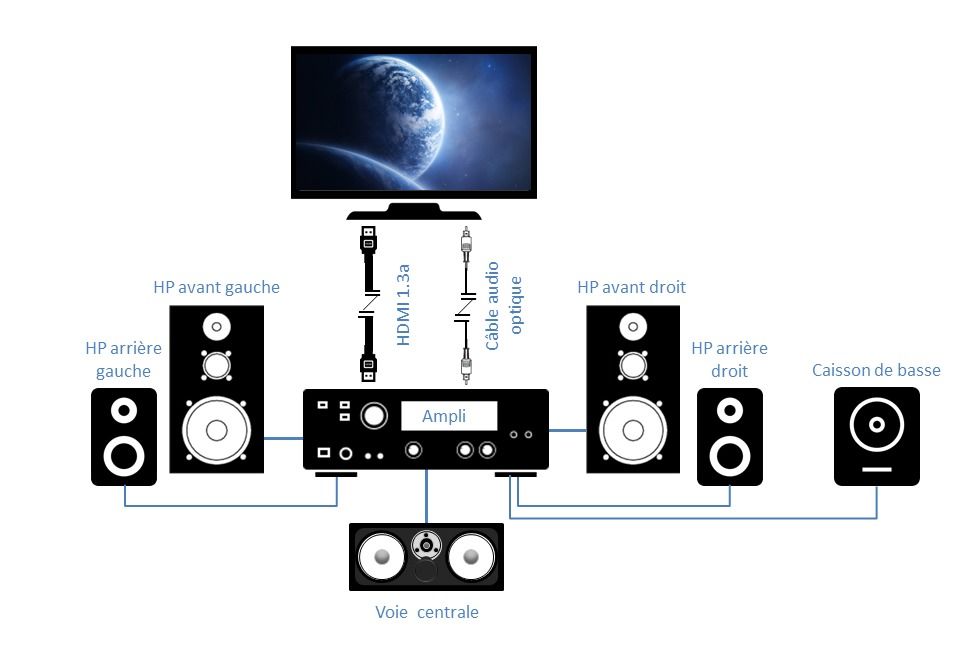

La distribution du son sur les différents canaux est assuré par l'amplificateur audio-vidéo (AVR). C'est lui qui est chargé d'extraire des différents canaux les informations audio pertinentes pour les diffuser sur les enceintes, en fonction de l'effet sonore recherché. C'est lui aussi qui fait transiter le signal vidéo vers la télévision. C'est donc une pièce maîtresse du dispositif.

Ce système finalement très classique fonctionne en 2 dimensions uniquement : de gauche à droite et d'arrière en avant. Il lui manque donc une dimension qui est de bas en haut. On a rajouté cette troisième dimension via des standards comme le Dolby Atmos. Le Dolby Atmos permet de localiser précisément les effets sonores, en hauteur, en largeur et en profondeur. Il peut s'agir par exemple de placer précisément les bruits et les conversations de différentes personnes dans une salle de restaurant. En plus de la musique d'ambiance diffusée dans toute la salle et donc reproduite par toutes les enceintes, il est alors possible de positionner précisément la conversation d’une personne située à un point de la pièce, le grincement d’un couteau sur une assiette à une autre table et le ronflement des brasseurs d'air au dessus des protagonistes de la scène.

Le Dolby Atmos nécessite une ou deux paires d'enceintes spécifiques, orientant le son vers le plafond pour qu'il y soit réfléchit. Avec 1 paire d'enceinte Atmos et un système 5.1, on obtient un système 5.1.2. Avec 2 paires d'enceintes Atmos, on obtient un système 5.1.4.

A noter qu'il existe également des barres de son multi-canal compatibles Dolby Atmos. Elles représentent une alternative très compactes aux traditionnels packs d'enceintes. Elles sont pour cela équipées de haut-parleurs dédiés, positionnés sur le dessus de la barre de son et dirigés vers le plafond par lequel les effets Dolby Atmos sont alors réfléchis vers les spectateurs.

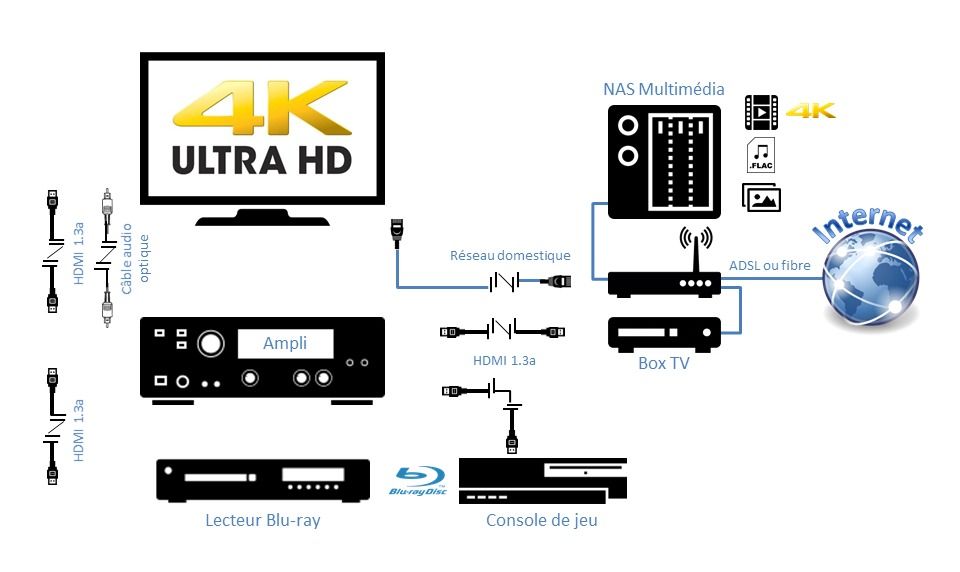

2 - Ma configuration Full HD

Pour ma part, je dispose d'un simple système 5.1, et c'est déjà beaucoup de câbles à gérer. Peut-être me laisserais-je un jour tenter par le 5.1.2 ou un 7.1 mais pour le moment, je me contenterai d'adapter mon home cinéma à un nouvel arrivant. Un nouvel écran 4K. Avec une question centrale : tout mon système home cinéma était conçu pour le full HD, et articulé autour d'un ampli audio-vidéo qui ne supporte que le Full HD. Vais-je devoir tout changer ?

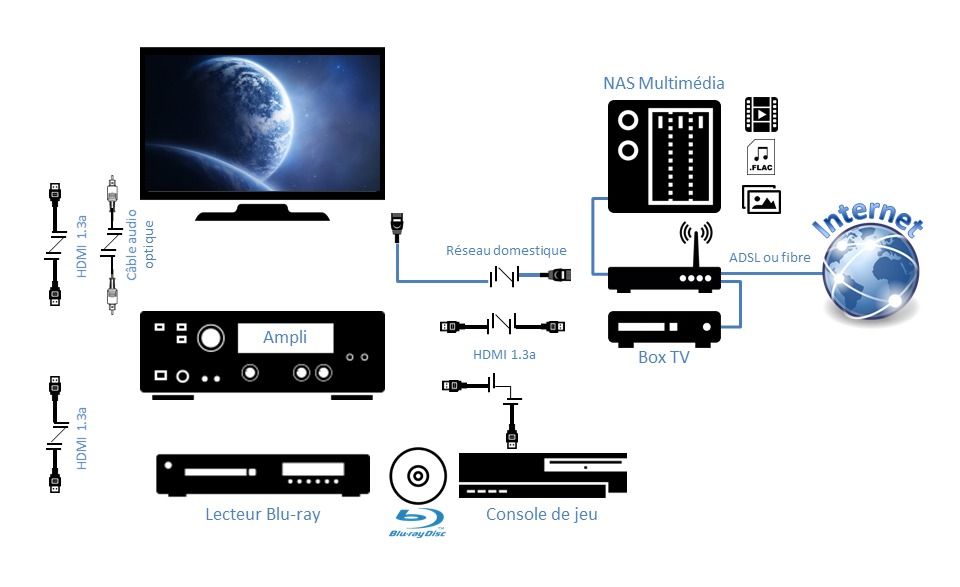

Au niveau du système audio, j'ai donc la configuration configuration suivante : le cœur du système est composé d'un amplificateur audio-vidéo qui me permet de diffuser le son de mes sources vers 5 hauts-parleurs (deux colonnes plus une voie centrale situées à côté de la télévision, deux enceintes bibliothèques sur le côté) et un caisson de basse.

Mon amplificateur AV a été l'un des premiers à supporter le HDMI 1.3a. La version est importante car c'est à partir de cette version que l'on pouvait diffuser un son de qualité sans perte sur 5 à 7 canaux sur un seul câble HDMI. Avant ça, il valait mieux utiliser les bons vieux câbles audio avec connecteurs RCA.

Côté source, j'ai branché un lecteur blu-ray, une console de jeu (une PS3) et ma box TV. J'ai aussi un NAS multimédia branché sur le réseau, qui me permet de visionner photo et vidéos sur ma télévision. Pour cela, j'ai naturellement branché mon téléviseur sur le réseau. Ce qui fait que je court-circuite mon home cinéma dès que je visionne une vidéo depuis mon NAS.

Pour retrouver un son digne de ce nom, j'ai dû connecter mon téléviseur à mon amplificateur avec un câble audio optique. Ainsi le son est redirigé par le téléviseur vers l'amplificateur qui fait son travail.

3 - Aparté sur la norme HDMI et le HDCP

3 - Aparté sur la norme HDMI et le HDCP

Construire un home cinéma reste un petit casse-tête que les constructeurs s'appliquent à rendre plus compliqué qu'il ne devrait l'être. Il faut en effet respecter certaines normes et compatibilités si vous voulez que cela fonctionne. De votre lecteur à la télévision, en passant par l'amplificateur audio-vidéo.

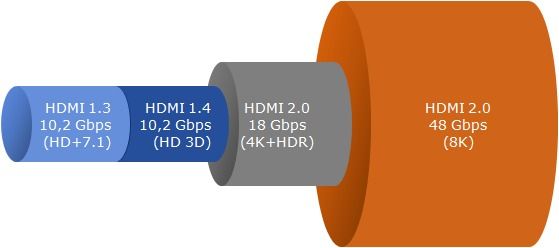

La première norme à maîtriser est la plus simple. Il s'agit de la norme HDMI. Cette norme a été conçue pour faire transiter la vidéo et le son sur le même câble, évitant ainsi l'inévitable plat de spaghetti que créent les câbles entre eux.

La première version intéressante de cette norme est la 1.2. Le HDMI 1.2 est la norme minimale, car elle fournit audio et vidéo sur un seul câble. Elle supporte aussi les formats audio du SA-CD. Mais ce n'est pas malheureusement pas suffisant. Car dès que l'on veut faire du multi-canal (c'est à dire diffuser du son sur plus de 2 hauts parleurs en stéréo), il faut passer a minima à la version 1.3.

Le HDMI 1.3 est la première version à supporter les formats audio haute-résolution multi-canaux 7.1 sans perte, comme le Dolby TrueHD, DTS-HD et DTS-MA (Master Audio). Ceci a son importance puisque la bande son des disques Blu-ray est encodée dans ces formats et que c’est le minimum requis pour être en mesure d'en profiter avec son home cinéma. Cela se traduit techniquement par :

-

Une augmentation de la bande passante (passant de 4,95 Gbit/s à 10,2 Gbit/s), ce qui permet de faire passer le son mais aussi d'améliorer la qualité des couleurs :

-

Un support du Deep Color avec 30-bit, 36-bit et 48-bit sRGB ou YCbCr comparé au 24-bit sRGB ou YCbCr dans les précédentes versions HDMI

-

Une prise en charge d’un espace de couleurs 1,8 fois plus large que le sRGB : xvYCC

-

Des améliorations techniques surtout à destination des constructeurs :

-

La définition de câble de catégorie 1 et 2. Le câble de catégorie 1 correspond à une fréquence pixel max. de 74,25 MHz tandis que la catégorie 2 correspond à une fréquence pixel max. de 340 MHz.

-

La définition d’un nouveau connecteur de Type C (mini-HDMI) pour appareils portables

-

-

De nouvelles fonctions directement perceptibles pour les utilisateurs

-

Une nouvelle fonction Lip-sync pour une synchronisation automatique de l’image et du son

-

Le Support du Dolby TrueHD et DTS-HD Master Audio7, format compressés sans perte de qualité des disques Blu-ray et HD DVDs

NB : Les versions a, b, b1 et c ne sont que des ajustements techniques sans conséquence sur l'utilisateur. N'en tenez pas compte.

Le HDMI 1.4 ajoute le support de la 3D (en résolution Full HD). Il a été conçu pour cela. Il offre ainsi des débits qui permettent non seulement le support de la 3D stéréoscopique mais aussi de la 4K (hors HDR). Cela se traduit par :

-

Le support de la 3D stéréoscopique

-

Le support des résolutions 4K (4096×2160 à 24 Hz) et UHD (3840×2160 à 24 Hz / 25 Hz / 30 Hz)

-

Le support de l'ARC (Audio Return Channel) qui permet de faire transiter les flux audio dans le sens retour (typiquement de votre téléviseur vers votre amplificateur). Ceci permet ainsi d'émettre sur votre système home cinéma le son issu de votre téléviseur. Pratique quand on fait du streaming (Netflix ou autre) depuis sa TV.

-

La possibilité de servir de câble réseau avec une vitesse de 100 Mbps : plus besoin de brancjer sa télé sur sa box internet déjà saturée...

-

L'ajout d’espaces colorimétriques comme l’Adobe RGB

-

La définition d'un nouveau connecteur (micro-HDMI) pour les appareils portables, 50 % plus petit que le mini-HDMI introduit par la norme 1.3.

Le HDMI 2.0a (et b) apporte le support de la 4K et du HDR qui requièrent des débits plus importants (18 Gbits/s contre 10 Gbps pour la 1.4). Et c'est donc celle-là qui nous intéresse. Puisque sans HDR, la 4K n'a que pour seul intérêt d'avoir un écran plus grand. Sans pouvoir bénéficier des couleurs et des niveaux dynamiques de luminosité de la HDR.

Quant à la version HDMI 2.1, elle a été introduite pour supporter les débits de la 8K, soit 48 Gbits/s. Et potentiellement le retour gagnant de la 3D dans ces résolutions d'ici quelques décennies.

Le schéma suivant résume brièvement les usages de chaque norme. Vous pourrez vous reporter à la page HDMI de wikipédia pour les débits nécessaires à chaque format, fréquence et profondeur de couleur.

Mais au HDMI les constructeurs ont eu la mauvaise idée d'associer le HDCP (High-Bandwidth Digital Content Protection), un procédé électronique et logiciel élaboré par Intel destiné à protéger de la copie les flux numériques vidéo et audio haute définition. C'est l'équivalent du DRM (Digital Rights Management), censé protégé la musique numérique et que les éditeurs ont fini par abandonner.

Les premières versions HDCP (1.xx) ne protégeaient que certaines connectiques "physiques" (au travers d'un câble donc). La version 2 du protocole, qui a fait son apparition en 2008, peut être utilisée indépendamment de la connectique, y compris sur les transmissions sans fil.

La version HDCP 2.1 du protocole, en sus de corriger quelques bugs, intègre une fonctionnalité permettant d'autoriser, ou non, le transfert des flux sur des appareils équipés en HDCP 1.x, ce qui autorise une certaine forme de rétrocompatibilité.

La version HDCP 2.2, élaborée pour protéger les flux 4K n'est pas rétrocompatible avec les autres versions (sauf à utiliser un boîtier spécifique de type HDFury splitter), car elle nécessite un matériel spécifique et les mises à jour logicielles n'y feront rien.

Quant à la version HDCP 2.3, rétrocompatible avec la 2.2 (dieu merci), elle a été introduite pour protéger la 8K et est donc logiquement couplée avec le HDMI 2.1.

Pour parfaire les choses, il vous faut des câbles HDMI certifiés pour un débit de 20 Gbits. Prendre des câbles certifiés à des débits inférieurs vous fera perdre en qualité d'image et de son, et prendre des câbles à des débits supérieurs vous fera simplement gaspiller votre argent, aucune source n'émettant aujourd'hui au-delà des 20 Gbps.

4 - Surtout ne rien changer

Me voilà donc avec une télévision 4K, avec des ports HDMI 2.0b supportant le HDCP 2.2 pour une résolution maximale de 60fps @ 2160p. Ouf, je suis donc prêt à recevoir une source 4K HDR.

Ma priorité est de pouvoir continuer à recevoir la télévision via la box de mon opérateur Internet et sa fibre - cela fait longtemps que j'ai abandonné l'antenne TNT - et de lire mes films, que ce soit en streaming depuis mon NAS ou depuis mon lecteur de blu-ray (full HD).

Ma box TV n'est pas compatible 4K, mais peu importe. Il n'y a pas encore de vrai contenu 4K et je vais donc me contenter de l'upscaling de la télévision (sans HDR donc). Il suffit de raccorder mon amplificateur audio-vidéo à ma télévision 4K, via l'interface HDMI 1.3a de l'amplificateur. Et hop le tour est joué. Je note une nette amélioration, surtout liée à l'écran OLED plus qu'à la 4K qui n'est de fait que du HD mis à l'échelle par le téléviseur. L'image des quelques chaînes qui émettent encore en SD sont d'ailleurs assez sales.

Mais je n'ai pas dit mon dernier mot : je génère par ailleurs une copie numérique d'un blu-ray 4K acheté en avance et le stocke sur mon NAS. Me voilà capable de visionner depuis ma télévision du contenu 4K HDR ! le son transite toujours quant à lui par le câble optique numérique. Et c'est c'est vraiment beaucoup beaucoup mieux...

Cela reste un peu limité je vous l'accorde. Il est urgent de pouvoir disposer d'une vraie source 4K HDR. Le hic reste que mon amplificateur audio-vidéo n'est pas compatible. Faut-il que je change tout d'un coup, ou puis-je acheter l'un après l'autre, et dans quel ordre ?

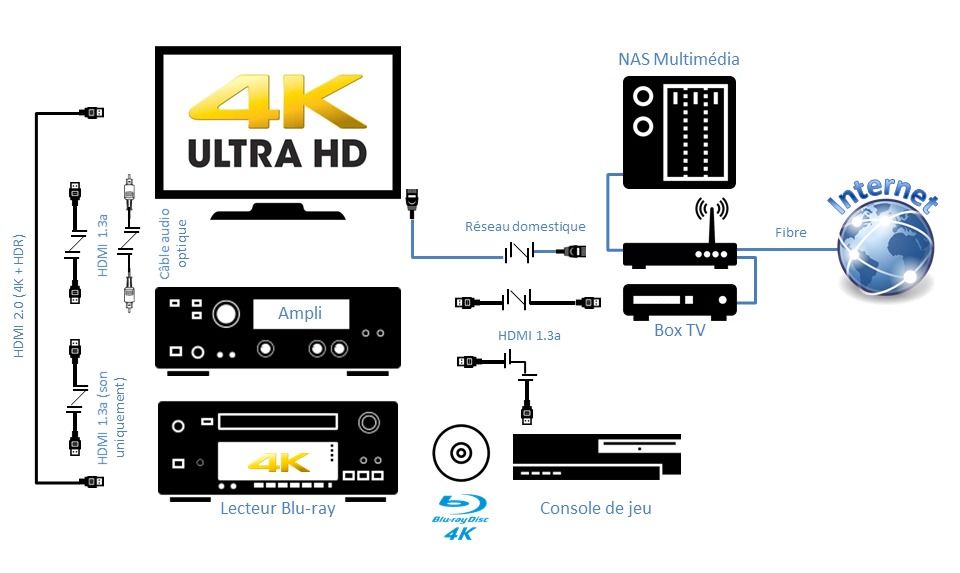

6 - Scénario 1 : acheter un lecteur blu-ray 4K HDR

L'avantage de ce scénario est de pouvoir disposer immédiatement de la meilleure source audio et vidéo Haute Définition. C'est aussi la moins coûteuse, un lecteur blu-ray coutant moins cher qu'un amplificateur home cinéma.

Il faut pour cela que le lecteur blu-ray dispose de 2 sorties HDMI (comme le Sony UBP-X800 ou le Panasonic DP-UB820), l'une utilisée pour diffuser l'image, et qui fonctionne donc en HDMI 2.0/HDCP 2.2, tandis que l'autre diffuse le son vers l'amplificateur AV, en HDMI 1.3.

Il suffit donc de raccorder la sortie audio du lecteur à l'AVR (Audio-Video Receiver ou amplificateur Audio-Vidéo) et de raccorder la sortie vidéo à la TV directement, en court-circuitant l'AVR. Comme le montre le schéma ci-dessous.

L'inconvénient de ce scénario est qu'il complexifie un chouïa le câblage et la configuration des entrées-sorties des équipements. Et qu'il est vite limité. Il faut ensuite mettre à jour impérativement l'AVR pour pouvoir continuer à mettre à jour ses équipements, sauf à raccorder tout sur le téléviseur. Mais on perd alors tout l'intérêt du Home Cinéma.

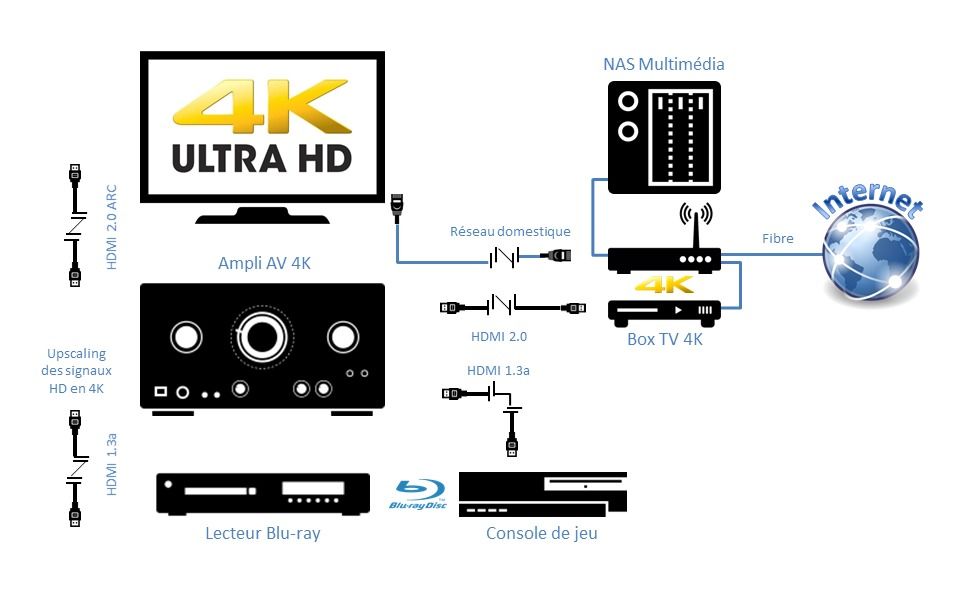

7 - Scénario 2 : mettre à jour son amplificateur audio-vidéo

Ce scénario permet de reconcentrer toutes les sources, qu'elles soient 4K ou pas sur l'AVR : Box TV, lecteur Blu-ray, console de jeux, lecteur de CD, etc.

En utilisant la fonction ARC (Audio Return Channel) de ma prise HDMI 2.0, je peux même supprimer le câble audio optique pour n'avoir plus qu'un seul câble. Il faut que je me branche à la prise HDMI ARC du téléviseur ; elle est généralement repérée par le symbole ARC. L'idéal serait d'avoir une prise eARC (e pour Enhanced) pour véhiculer un son multi-canal sans perte, mais je me contenterai du son 5.1 compressé.

Dans ces conditions, je peux passer à la Box TV 4K de mon opérateur Internet, c'est le plus facile et le moins cher. Mes autres sources (lecteur blu-ray et console de jeu) restent en Full HD, et leur signal est mis à l'échelle (upscaling) par l'AVR.

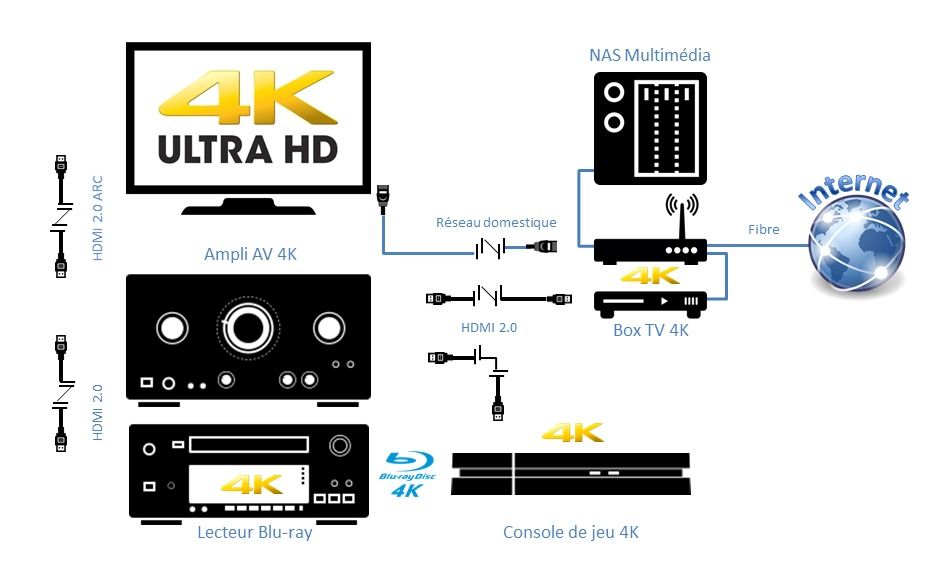

8 - Le résultat final

Une fois tout mis à jour, l'ensemble a retrouvé sa cohérence : résolution 4K, ports HDMI 2.0 et HDCP 2.2.

Enfin, pour piloter toutes ces boîtes, j'ai opté pour une télécommande universelle, mais je vous en parlerai une autre fois.

Alors, à jour... Oui, jusqu'à la prochaine mise à jour, peut-être constituée de la 8K couplée à lune 3D stéréoscopique enfin correcte (sans lunettes, visibles par tous et avec une offre de films digne de ce nom). Un jour peut-être...

Passer du Full HD au 4K

Paris, le 10 juin 2019

Quand j'étais petit garçon, je repassais mes leçons devant une télévision noir et blanc, sur un écran cathodique. Et bien des années plus tard, je chassais mes idées noires devant une télévision couleur. Mais avec toujours ce fameux écran cathodique bombé au format 4/3. Et cette télévision m'a duré des années, des années. Tant qu'elle marchait, je refusais de la jeter. Elle vieillissait quand même et les couleurs tiraient vers le vert dans un coin. J'ai fini par la donner à un étudiant sans le sou, loin de chez lui. Et par m'acheter un grand écran plat, 40 pouces - soit 101,6 cm de diagonale - Full HD... Pour moi, ce fut une orgie de pixels et de grand écran.

Et comme le temps s'accélère, je n'ai mis qu'un peu plus de 10 ans à basculer vers la 4K. J'ai évité l'écueil de la 3D, mais voilà que se pointe la 8K. Et pourquoi pas la 16K bientôt ? A quoi rime cette course au pixel et à la haute définition ? Faisons une pause et prenons un peu de recul.

Une histoire de format et de pixels

L'écran cathodique de mon enfance avait une définition standard (en anglais Standard Definition, SD ou 480p), soit 720 pixels x 480 pixels. Les pixels sont les petits carrés qui composent une image (voir photo ci-contre). Plus ils sont nombreux, à taille d'image constante, et plus l'image est détaillée. Détail qui a son importantce, l'écran cathodique avait un format 4/3, nombre qui désigne les proportions de l’image ou de l'écran de télévision. Soit le rapport entre la largeur et la hauteur. 4/3 représente donc 1 cm de hauteur pour 1,33 cm de largeur. Ce format correspond au format historique des films de cinéma muet et a donc été simplement repris par la télévision à sa naissance.

L'écran cathodique de mon enfance avait une définition standard (en anglais Standard Definition, SD ou 480p), soit 720 pixels x 480 pixels. Les pixels sont les petits carrés qui composent une image (voir photo ci-contre). Plus ils sont nombreux, à taille d'image constante, et plus l'image est détaillée. Détail qui a son importantce, l'écran cathodique avait un format 4/3, nombre qui désigne les proportions de l’image ou de l'écran de télévision. Soit le rapport entre la largeur et la hauteur. 4/3 représente donc 1 cm de hauteur pour 1,33 cm de largeur. Ce format correspond au format historique des films de cinéma muet et a donc été simplement repris par la télévision à sa naissance.

Pour répondre à l’arrivée de la télévision et conserver ses parts de marché, l’industrie du cinéma américaine a eu recours à d'autres formats, plus larges. Ainsi est né le cinémascope avec un ratio de 24/9. Ainsi que les fameuses bandes noires en haut et en bas du petit écran quand on ne retaillait pas le film pour le passer à la télévision. Cette différence de format est simplement dû à une petite guéguerre entre industries et non à une volonté de meilleure qualité ou que sais-je encore.

En parallèle, l'industrie a développé un nouveau format d’image pour mieux s’adapter à la vision humaine et à la diffusion de films, le format 16/9. On a vu certains écrans cathodiques adopter ce format mais ce dernier a vraiment décollé avec l'arrivé des écrans plats (et aux coins vraiment carrés).

-

Les premiers écrans HD accessibles au format 16/9 avaient une définition dite de 720p, correspondant à la norme d'affichage HD Ready (1280 x 720 pixels). Soit une belle arnaque quand même de la part des fabricants, puisque l'image avait une définition de moitié inférieure au vrai HD. On aurait du l'appeler Half HD, mais ce n'est pas très vendeur...

-

Les écrans dit Full HD ont une définition de 1080p (1920 pixels en largeur x 1080 pixels en hauteur)

-

Les écrans 4K ou UHDTV1 (appelée aussi UHD-4K) ont une définition de 2160p (3840 x 2160 pixels), soit 2 fois plus de pixel en hauteur et 2 fois plus en largeur qu'un full HD.

-

Les écrans 8K ou UHDTV2 (appelée aussi UHD-8K) ont une définition de 4320p (7680 x 4320 pixels). soit 2 fois plus de pixel en hauteur et 2 fois plus en largeur qu'un 4K

Certains cinéphiles diront que les écrans 4K et 8K ne sont que UDH et pas vraiment 4K (8K), parce qu'il leur manquent des pixels, mais c'est simplement la guéguerre de format entre cinéma et télévision qui se poursuit. Faisons un petit aparté pour clore ce débat plus qu'inutile.

L’industrie du cinéma numérique a d’abord commencé à travailler en 2K (image filmée avec une résolution de 2048 x 1080 pixels avec un ratio d'environ 17/9 - je dis environ car 2048/1080 ça ne fait pas 17/9 ) puis en 4K avec une image filmée en 4096 x 2160 pixels et un ratio de 17/9. Ce format d’image en 17/9 est ensuite travaillé et recoupé afin d’obtenir le fameux format cinémascope (24/9).

Un écran de télévision 4K a une définition de 3840 pixels en largeur pour 2160 pixels en hauteur. 2160 pixels en hauteur avec un ratio de 16/9 font bien 3 840 pixels en largeur (2 160 * 16/9 = 3 840). Mais le cinéma utilise un ratio de 17,07/9, soit donc 4096 pixels en largeur (2 160 * 17,07/9 = 4 096) ! Notons que cette différence a toujours existé, même en Full HD : le monde du cinéma travaillait en 2K avec une définition de 2048 x 1080p (soit un ratio d'environ 17,07/9 là encore) alors que nos écrans de TV étaient en 1920 x 1080p (16/9). Nous avons donc bien le même nombre de pixels en cinéma 4K ou en télévision 4K, au format prêt. Ouf.

Notons qu'il ne faut pas confondre la définition d'un écran, qui se compte en nombre de pixels, quelle que soit la taille de l'écran et sa résolution qui est le produit du nombre de pixels en hauteur par le nombre de pixel en longueur. Ce qui va varier avec la taille de l'écran, c'est la densité de pixels (DPI ou PPI). Un écran 4K a une résolution de (2160 * 3840) = 8,3 MPixels. Mais la densité de pixel sur un petit écran de 40 pouces sera beaucoup plus importante que sur un écran de 55 pouces.

Maintenant que le nombre de pixels des écrans n'a plus de secrets pour vous, voyons ce qu'a apporté chaque norme (Full HD, 4K, 8K) par rapport à la référence qu'est le SD au format 4/3 de nos télévisions cathodiques.

Les apports du Full HD

Ne revenons pas sur la norme HD Ready, qui n'était là que pour vendre des équipements qui n'étaient pas encore prêts pour le Full HD. Cette dernière norme a permis de passer des 480 pixels de la SD à 1080 pixels, soit 2,25 fois plus de pixels. Et avoir plus de pixels a 2 intérêts majeurs :

-

Avoir une image d'une meilleure définition. A taille d'image identique, la densité de pixel augmente (Pixel per Inch ou PPI). L'image est plus réaliste et plus proche de la vision humaine. Avouons que les images SD que nous pouvons encore visionner piquent les yeux... Notons enfin qu'avec le passage du 4/3 au 16/9, on est aussi plus proche de l'angle de vision humaine. Mais cela n'a rien à voir avec le nombre de pixel à proprement parler.

-

Avoir une taille d'écran plus grande, à distance égale entre le spectateur et l'écran. Si on augmentait la taille de l'écran sans augmenter le nombre de pixels, le spectateur situé à la même distance de l'écran distinguerait les pixels. L'image serait alors dégradée. Ce phénomène tient essentiellement à la résolution de l'oeil humain, c'est à dire la capacité de l’œil à discerner deux points contigus entre eux. imaginez-vous à la plage en train d’observer le sable sur la plage. En regardant de près, vous pouvez facilement en discerner les grains qui la compose. Par contre, plus vous regardez au loin, plus il vous devient difficile, voire impossible, de distinguer chacun des grains. La perception de la résolution tient donc principalement dans la distance.

Les tests menés par Que Choisir sur la distance idéale entre le spectateur et l'écran ont montré que :

-

Pour une même taille d’écran, la distance optimale dépend peu de la résolution d’image (Full HD ou UHD).

-

Le rapport entre la distance optimale et la taille de l’écran est toujours à peu près le même quelle que soit la taille de l’écran. Il est d'environ 2,2 pour le 40" et de 2,3 à 2,7 pour le 55".

-

Grâce à la HD, on a donc pu adopter de plus grands écrans et dire adieu la petite voire minuscule lucarne de l'écran cathodique ! Et avoir ainsi une expérience plus immersive, plus proche de celle du cinéma, tout en ayant des images de meilleure qualité. Que du bonheur. Ou presque. Parce qu'avec la cure de minceur qu'ont suivi les écrans, on a perdu en qualité de son. Il a fallut recourir aux systèmes de home cinéma (comme ci-dessous) ou aux barres de son pour retrouver un vrai son.

En 2004, la taille moyenne des écrans cathodiques était de 27 pouces. En 2014, la taille moyenne des écrans plats étaient de 37 pouces. En 2015, elle était de 40 pouces et de 45 pouces en 2018 (source statista.com). On devrait atteindre les 50 pouces (en moyenne) en 2022. Mais peut-on réellement aller au delà ? Sachant que dans le même temps, la surface moyenne de nos logements à tendance à se réduire comme peau de chagrin...Bien sûr que non. Car plus votre écran est grand, plus il vous faut du recul pour englober la totalité de l'image. Vous ne regardez pas l'écran de 6 pouces de votre smartphone à la même distance que votre télévision de 55 pouces, non ? Sans parler de l'effet désastreux d'un écran trop grand dans une pièce trop petite...

Mais il n'y a pas que la taille qui joue ! Le 1080p a permis d’offrir aux consommateurs une solution enfin conforme aux formats du cinéma (j'exclue la période du cinéma muet où il n'y avait pas de télévision), de la production au visionnage. Les masters des films et séries étant en 2K (2048 x 1080p), il suffisait de couper un peu les bords à droite et à gauche pour faire un film qui soit adapté aux téléviseurs Full HD (1920 x 1080 pixels) avec un résultat optimal sans traitement de l'image (mise à l'échelle). Le blu-ray, média physique du Full HD, s’est ainsi popularisé très naturellement, après le DVD qui lui était au format SD et donc dégradé par rapport au format 2K du cinéma.

Les apports de la 4K

La 4K apporte 2 fois plus de pixels que le Full HD, tant dans la hauteur que dans la largeur. Soit 4 fois plus de pixels en tout...Ce qui permet encore une fois d'améliorer et qualité de l'image et taille de l'écran. On peut donc passer à des tailles de l'ordre de 55 à 77 pouces en passant par les 65 pouces. D'ailleurs ne cherchez pas de téléviseur 4K d'une taille inférieur à 55 pouces. Cela n'existe pas car cela n'a pas d'intérêt. A 40 pouces, vous ne verrez pas de différence entre un Full HD et une 4K. Et avec un 55 pouces, la différence ne sera pas fulgurante.

Mais comme je l'ai dit, la course à la taille a ses limites, celles de nos salons. Alors est-ce vraiment si intéressant que cela de passer à la 4K ? En soi pas tellement, mais il y a plusieurs choses qui peuvent vous faire craquer :

-

Le HDR ou High Dynamic Range : C'est l'apport n°1 de la 4K. Le HDR permet d'afficher une image avec des écarts de luminosité plus marqués entre sa partie la plus sombre et sa partie la plus claire qu'avec les téléviseurs standards (SDR). Et comme l’œil humain est extrêmement sensible aux variations d'intensité lumineuses, le résultat à l'image est immédiatement perceptible : on observe grâce au HDR un contraste intra-image plus important, plus de gradation dans l'échelle de luminosité, donc également dans les couleurs, et plus de détails visibles dans les parties les plus lumineuses comme dans les parties les plus obscures de l'image.

Le SDR, utilisé par le Full HD notamment, est calé sur la limite physique du tube cathodique. Il utilisait un codage couleurs sur 8 bits, soit 256 valeurs possibles, couvrant environ 35% du spectre visible par l’œil humain (soit pas grand chose au final). Alors que le HDR s'approche de la sensibilité réelle de l’œil humain au contraste et autorise une large plage de luminance. Techniquement, la norme HDR impose une profondeur de couleurs codée sur 10 bits minimum, un espace colorimétrique ayant capacité à afficher 90% ou plus de l'espace colorimétrique DCI-P3 (espace colorimétrique utilisé pour le cinéma numérique, couvrant environ 85% du spectre visible par l’œil humain) et une luminosité maximale d'au moins 1000 cd/m² avec un niveau de noir inférieur ou égal à 0,05 cd/m² pour les téléviseurs LED ou une luminosité maximale d'au moins 540 cd/m² avec un niveau de noir inférieur ou égal à 0,0005 cd/m² pour les téléviseurs OLED (norme SMTPE ST2084 EOTF).

Le HDR se décline en :

-

HDR10 (standard ouvert, libre de droit, appelé HDR 10 parce qu'il utilise une échelle de quantification des couleurs sur 10 bits).

-

HDR HLG (Hybrid Log Gamma) pour la diffusion du streaming en 4K développé conjointement par la BBC et la NHK.

-

Dolby Vision : Dolby Vision est une norme propriétaire et une version amélioré du HDR, permettant de définir le HDR frame par frame et non plus pour tout le film. Elle propose une quantification sur 12 bits des couleurs (soit 1024 possibilités). C'est une contrainte pour toute la chaîne de production et de diffusion de l'image, mais c'est ce qui garantit que l'affichage final sera véritablement conforme à l'originale voulue par le réalisateur; C'est un complément naturel du Dolby Atmos (son 3D).

-

HDR10+ : Standard développé par l'UHD Alliance pour concurrencer le Dolby Vision et qui a l'avantage d'être gratuit alors que le Dolby Vision est payant. Comme ce dernier, le standard HDR10+ exploite des métadonnées dynamiques intégrées au flux vidéo pour que le diffuseur compatible (TV, vidéoprojecteur) puisse en optimiser l'affichage, scène par scène. Ce standard ouvert est soutenu notamment par la 20th Century Fox, Panasonic Corporation et Samsung.

-

HDR Pro ; ce n'est pas un label ni une norme. Il est censé être supérieur au SDR, mais de combien, personne ne le sait...

-

-

Les technologies LED et OLED. Ces technologies ne sont pas propres à la 4K mais si vous aviez un vieil écran LCD (Liquid-Crystal Display) ou un écran Plasma très énergivore, vous pourriez être tenté d'adopter l'OLED (Organic Light Emitting Diode).

Sur une ancienne TV LCD, les cristaux liquides étaient illuminés par des tubes fluorescents situés à l'arrière de l'écran. Sur les TV LED, les cristaux liquides sont toujours présents mais sont illuminés par des diodes électroluminescentes (LED). Cela permet de diminuer l’épaisseur de l'écran, son poids, d’apporter des meilleurs niveaux de contrastes, des couleurs plus riches, des noirs plus profonds, et aussi de diminuer la consommation d’électricité. A l’inverse d’une TV LED, sur une TV OLED, chaque pixel va produire sa propre lumière pour générer l’image. Cela permet ainsi d'atteindre un niveau de noir sans égal (il est possible d’éteindre complètement le pixel) et donc des niveaux de contrastes très élevés, d'éviter le phénomène de « clouding » que l’on voit fréquemment sur les TV LED (le clouding est dû au rétroéclairage des LED qui n’est pas uniforme sur la dalle, provoquant des « nuages » gris sur les images sombres), d'avoir un angle de vision étendu et un très bon temps de réponse (on parle de 0.1 ms de temps de réponse contre 2 ms pour les meilleures TV LED). Enfin, la technologie OLED permet de réduire encore l’épaisseur de l’écran (se réduisant ainsi à seulement quelques mm d’épaisseur comme sur la LG Signature), et de diminuer toujours plus la consommation électrique.

Seul défaut à l'OLED, le risque de burn-in. Sur l’OLED, chaque pixel est indépendant et génère sa propre lumière. Dans le cadre d'une utilisation normale, les pixels vont s’user de manière à peu près homogène dans le temps. Mais en cas d’image fixe (comme le logo de la chaîne si vous n'en regardez qu'une par exemple), certains pixels vont s’user plus rapidement que d’autres. Ils n’ont alors plus le même niveau de luminosité, ce qui provoque un marquage de l’image.

Quant à la technologie QLED (Quantum-LED), ce n'est juste qu'une technologie LED de plus contrairement à ce qu'affirme Samsung, c'est à dire un système de rétroéclairage Edge-LED, avec tous ses inconvénients. La seule nouveauté est l'adoption d'un filtre Quantum-Dot plus perfectionné qui permet d'étendre l'espace colorimétrique pour afficher 100 % du spectre colorimétrique DCI-P3 et d'améliorer le rendement du système de rétroéclairage afin d'atteindre un pic lumineux plus élevé. Et c'est une technologie plus simple à maîtriser que l'OLED (que seul LG arrive à fabriquer à l'échelle industriel en ce qui concerne les grands écrans) et donc moins coûteux.

-

Le design de l'écran. L’écran incurvé n’améliore en rien la qualité d’image et peut même s’avérer gênant à cause des réflexions qu’il génère. Mais si vous aimez son design, pourquoi pas. Plus révolutionnaire, vous trouverez maintenant des téléviseurs ultra plats, avec processeur, haut-parleurs et connectique séparés de l'écran comme le LG Signature, ou le LG Signature OLED TV R, dont l'écran s'enroule pour se faire discret. Bien sûr ces technologies sont encore hors de prix et sont encore réservées à une portion congrue de personnes.

Le contenu suit-il ?

C'est bien beau d'avoir un écran 4K, encore faut-il que le contenu suive, qu'on puisse en profiter. Même si les capacités de mise à l'échelle (upscale) des écrans ont bien progressé (plus vite que ceux des amplificateurs audio-vidéo), pour profiter du 4K et de son apport principal, le HDR, il faut des sources 4K natives incluant le HDR. Jouer un blu-ray Full HD sur un écran 4K vous apportera une belle image, mais sans HDR.

Seuls les blu-ray UHD-4K (les vrais, gravés avec un master 4K et non 2K) vous procureront ce plaisir, avec un débit constant que ne vous permettra pas le streaming par exemple et qui est souvent nécessaire au HDR. Le bitrate d'un blu-ay 4K est en moyenne de 60 à 70Mbps (certains sont à 50, d’autres à 90 Mbps). Contre 30 à 40 Mbps pour un Full HD. Encore faut-il disposer d'un lecteur blu-ray 4K. La vente des médias physiques étant en chute libre, le nombre de constructeurs de bons lecteurs se fait rare. Mais j'aurais l'occasion d'y revenir dans un autre article.

Notons que si le 4K se généralise dans les films, le 2K est encore malheureusement de mise dans beaucoup d'effets spéciaux (appelés VFX dans le monde du cinéma, ou trucages pour les non-initiés). Ce qui fait que les effets spéciaux se verront beaucoup plus sur une télévision 4K ou 8K que sur une Full HD bien mieux adaptée au 2K. Car la 4K est impitoyable : on voit mieux les détails et donc les trucages aussi...Et pour distinguer un blu-ray 4K authentique d'un ersatz, certains sites comme senscritique vous indiqueront s'il s'agit d'un blu-ray avec master 4K ou pas. Pratique pour éviter de surpayer un disque pas vraiment 4K.

Quant à la télévision, si la TNT ne prévoit pas de diffuser de la 4K avant 2020, vous pouvez d'ors et déjà disposer de certaines émissions en 4K grâce à votre box TV. Il faut bien sûr disposer de la fibre et d'une box compatible (Orange, Free, SFR et Bouygues en proposent tous une). Sachez toutefois que seules quelques chaînes diffusent en 4K à ce jour : TF1, Canal+, OCS, Eurosport...Pour que toutes les chaînes s'y mettent, il faudra encore patienter.

Il existe aussi quelques rares sources de streaming émettant partiellement en 4K comme Youtube, OCS (Orange Cinéma Séries), Amazon Prime Video ou Netflix, qui supporte le HDR10 et le Dolby Vision. Encore faut-il disposer du bon abonnement Netflix (celui à 4 écrans qui permet d'avoir 4 écrans HD ou un écran 4K) et d'une liaison par fibre optique. Mais quand on regarde les débits affichés par Netflix, on déchante un peu : la 4K utilise des débits allant de 7 Mbps à 12 Mbps et la 4K HDR des débits de 9 Mbps à 15 Mbps selon les programmes. Le codec utilisé par Netflix, le HEVC, est toutefois presque 2 fois plus efficient que le codec des « anciens » bluray Full HD. On peut donc comparer les 15Mbps du 4K HDR de de Netflix aux 30 Mbps et à la qualité d’un blu-ray en 1080p. Aie oui ! un streaming 4K HDR équivaut peu ou prou à une qualité Full HD d'un blu-ray, le HDR en plus. On est encore loin du 4K HDR+.

Et la 8K ?

La 8K apporte 2 fois plus de pixels que la 4K, tant dans la hauteur que dans la largeur. Ce qui permet encore une fois d'améliorer et qualité de l'image et taille de l'écran... En 65 pouces et en deçà, la différence entre la 4K et la 8K ne se ressent pas, : à supposer que vous ayez un contenu 8K à afficher, pour une télévision de 50 pouces, il vous faudra vous asseoir à 60 centimètres ou moins de l’écran pour en voir les détails en pleine résolution. Mais à 60 cm, vous ne voyez évidemment plus l'image en entier. Il vous faudrait plutôt être à 2,5 m...

La 8K est bien plutôt destinée à des tailles d'écran allant de 77 pouces et au-delà....c'est à dire pour un marché de professionnels plus que de particuliers. Mais contrairement à la 4K qui apportait le HDR avec elle, le 8K n'apporte rien de plus que sa multiplication de pixels. Pire, elle pourrait ne pas supporter le HDR, les débits nécessaires à sa diffusion étant à ce jour inaccessibles.

En conclusion

Si la 4K a indéniablement apportée son lot d'innovations et d'améliorations, la 8K nous laisse à ce jour un peu dubitatif. N'aura-t-on droit qu'à une simple augmentation de pixels, un peu comme le faisaient les appareils photos numériques avant l'avènement des appareils hybrides qui ont secoué le marché ? Ou à de véritables innovations ? Seul l'avenir nous le dira. En attendant, la 4K suffira simplement au bonheur des plus nombreux, que ce soit grâce au streaming et son succédané de 4K, à la future TNT UHD ou aux rares blu-ray UHD-4K qui font encore figurent de derniers résistants face à la dématérialisation inéluctable. Mais qui disparaîtront un jour ou l'autre comme les SACD...

Suivre l'évolution des prix sur Amazon

Paris, le 22 avril 2019

Qu'on aime ou qu'on déteste, on ne peut pas ignorer la place qu'a pris Amazon dans notre vie et la façon dont cette entreprise a profondément modifié notre façon d'acheter. Dans un paysage où l'innovation est totalement absente (on achète encore dans son supermarché Carrefour ou Auchan comme on achetait il y a 20 ans), Amazon apparait comme un véritable trublion.

Avec une expérience client simple et efficace et un service irréprochable, une politique de prix tirée au cordeau, Amazon fait référence. Une domination qui s'accompagne comme souvent d'une face obscure, comme le dénoncent les nombreux articles de presse et enquêtes, la dernière ayant été diffusé le 13 janvier 2019 sur M6 dans Capital. Gaspillage, conditions de travail dans les entrepôts ou optimisation fiscale à outrance, tout y passe. Et pourtant Amazon reste solide leader de la grande distribution, avec le chinois AliBaba (et sa filiale grand public AliExpress).

Vendre sur Internet pour de nombreuses entreprises passe désormais par Amazon et son fameux MarketPlace. Amazon fait désormais comme le fait Google avec ses premiers résultats, il vend les premières places des résultats de son moteur de recherche, permettant aux entreprises vendeuses de gagner en visibilité. Quant au prix de la marchandise...il s'avère être le résultat d'algorithmes de calcul très savant.

Amazon change ses prix près de 2,5 millions de fois par jour, selon un algorithme similaire à celui qui calcule les prix de billets d’avions en ligne qui évoluent en fonction de la demande et de la date de la commande (le week-end c'est plus cher). L’algorithme d'Amazon va quant à lui compiler des milliards de données analysant les habitudes d’achats des consommateurs, les prix des concurrents, ou encore l’inventaire de ses stocks pour décider de ses prix.

Les produits les mieux vendus affichent des prix souvent bien placés, qui vous feront croire qu'Amazon est moins cher tout le temps sur tous les produits. Et en faisant vous courses sur Amazon, vous achèterez donc d'autres produits moins courants, mais bien plus cher que la normal. Pour éviter d'avoir à suivre les montagnes russes que fait faire l'algorithme aux prix d'Amazon, il existe une parade qui permet de savoir quel est le juste prix. Le suiveur de prix ! Deux sociétés s'en sont fait une spécialité, Keepa et CamelCamelCamel. J'ai testé les deux et voici mon verdict.

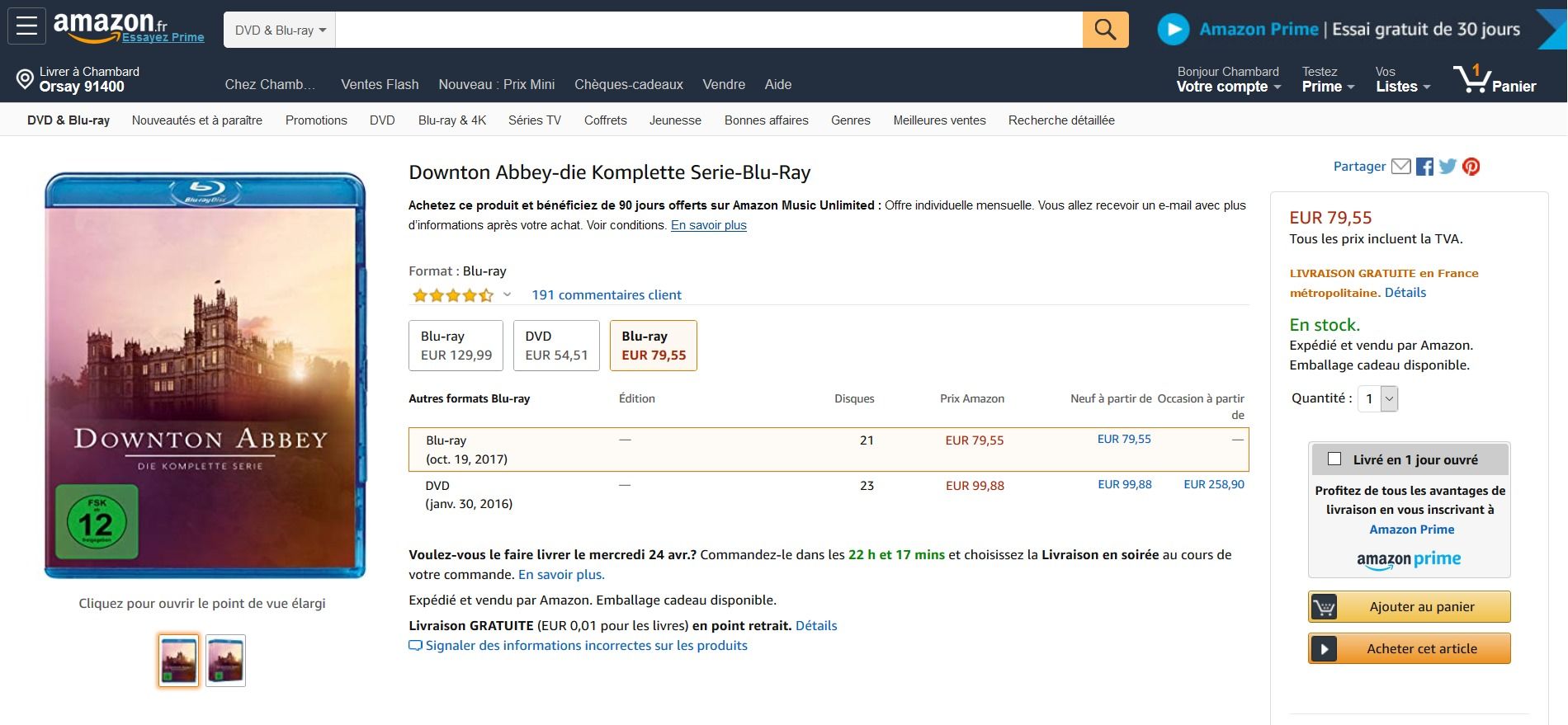

1 - La page Amazon de référence

J'ai pris une page Amazon de référence pour cet article, que je reproduis ici

Il s'agit de l'intégrale de la série "Downton Abbey" en blu-ray. Curieusement, Amazon me propose la version allemande en premier, au prix de 79,55 €, alors que je ne maîtrise plus la langue de Goethe depuis la terminale, et que la version française en cherchant bien est à 129,99 € sur le marketplace. Mais peu importe. Voyons ce que nous dit Keepa et CamelCamelCamel. Ou plutôt les add-ons que proposent ces outils pour Navigateur Firefox, Chrome, Opera ou Edge...

2 - Les prix selon Keepa

Keepa est l'un des plus anciens "suiveurs de prix". Et cela se voit sur l'interface un peu surannée. En cliquant sur "Rechercher", on peut chercher un article sur Amazon et afficher l'historique des prix.

Mais le plus simple est d'aller chercher l'extension Keepa sur le marketplace de votre navigateur préféré et de l'installer.

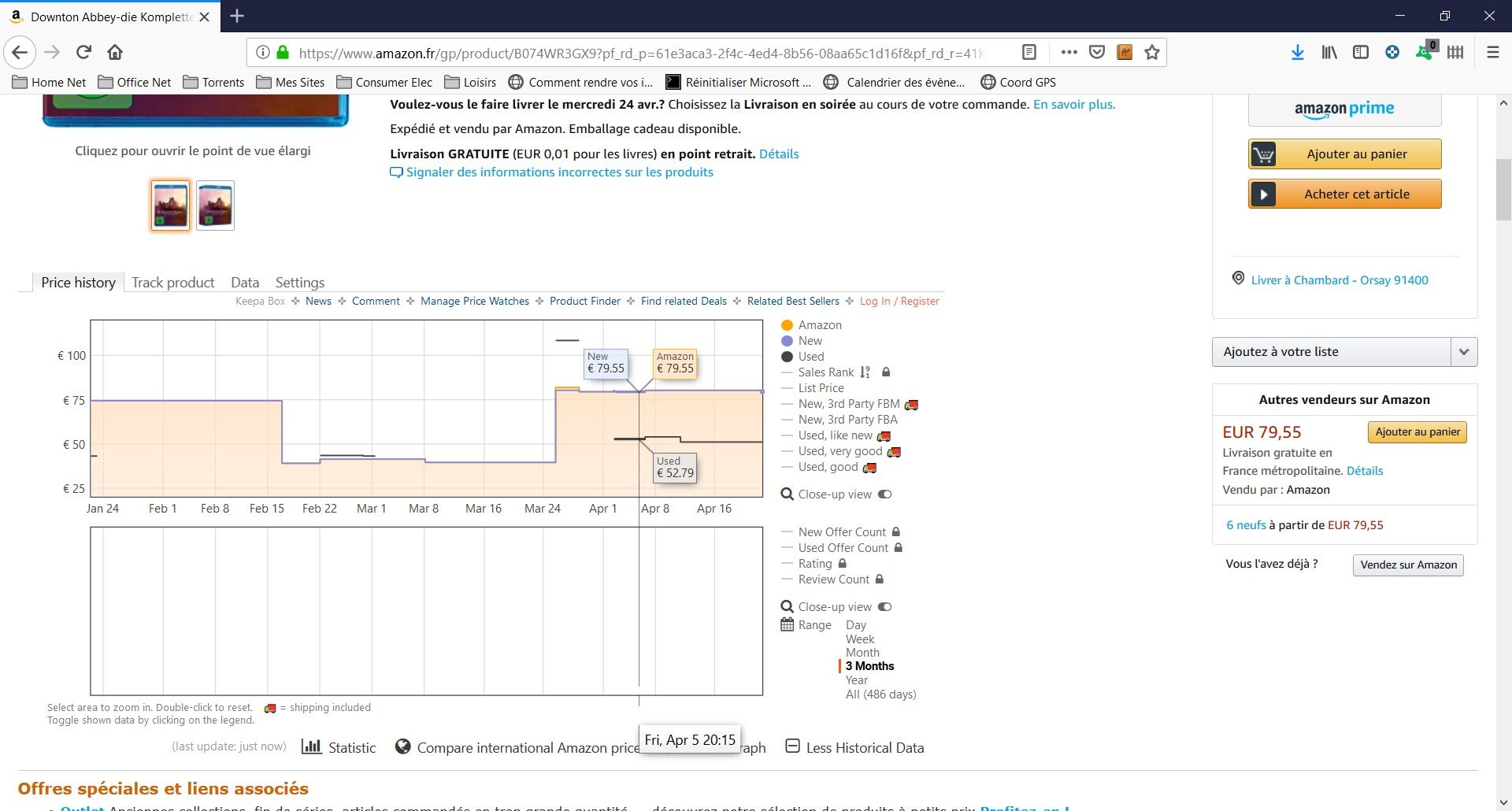

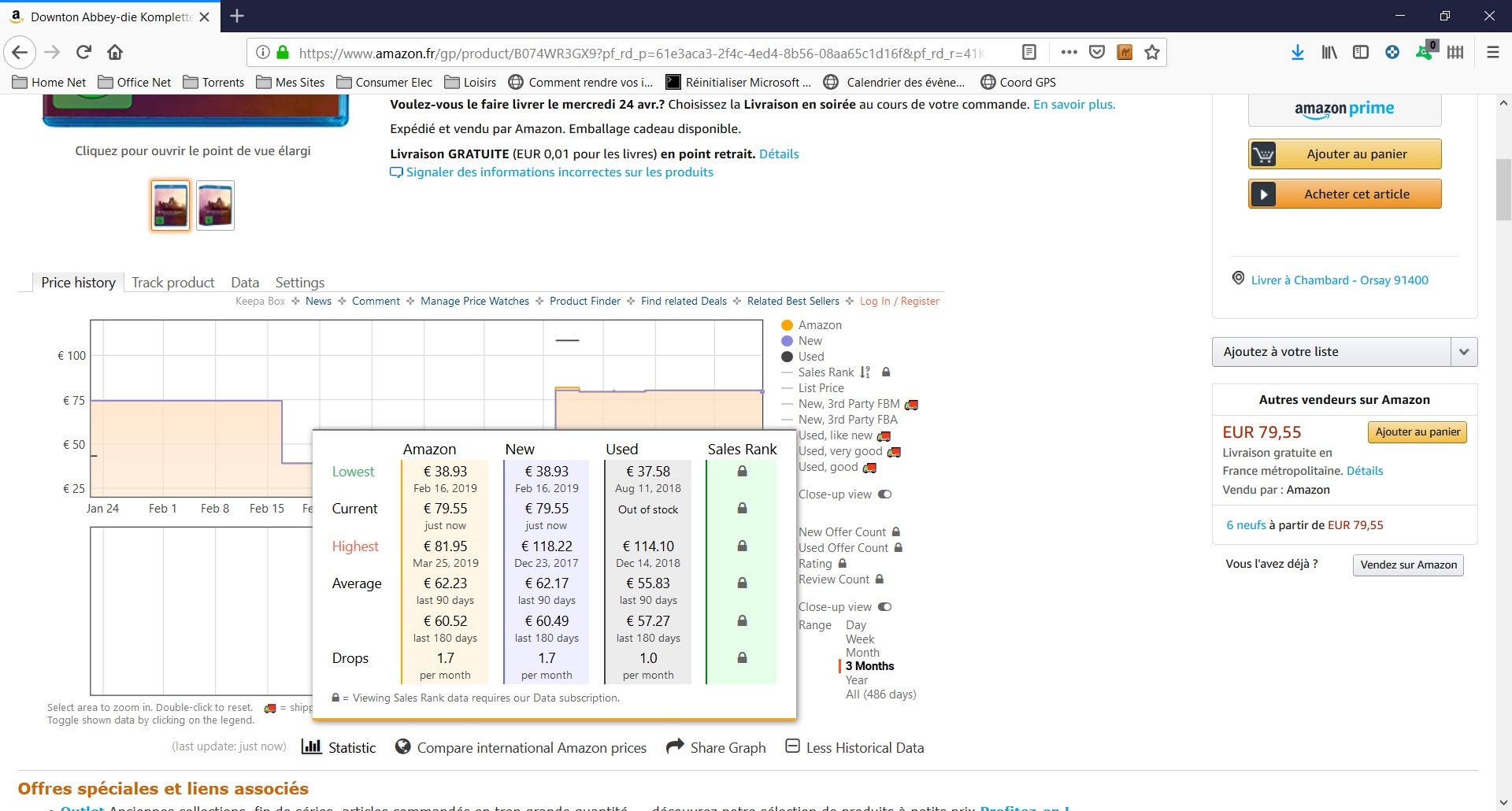

Une fois installé, l'extension vous permet d'afficher la liste des prix directement dans la page Amazon, plutôt que de coller le lien de la page Amazon sur le site de Keepa. Pratique non ? Pour moi, c'est magique...et quelque peu dérangeant. Une simple extension modifie la page du site Amazon...diantre. Voici donc ce que cela donne avec ma page de référence sur Downton Abbey...Le graphique des prix apparait juste dessous le produit, et en déplaçant la souris sur la courbe, on peut afficher les prix exacts jour par jour. On peut voir que le produit a également fait l'objet d'une forte baisse des prix entre (approximativement) le 16 février et le 24 mars.

Si je clique sur la petite icône "Statistic" tout en bas sous les graphes, je peux avoir les extrêmes rapidement.

Le prix le plus bas a été atteint le 16 février 2019 à 38,93 € par Amazon, et le plus haut prix le 25 mars 2019 avec 81,95 €...Certaines données ne sont accessibles qu'avec un abonnement premium payant, que je n'ai pas pris. Vous voyez donc un cadenas à la place.

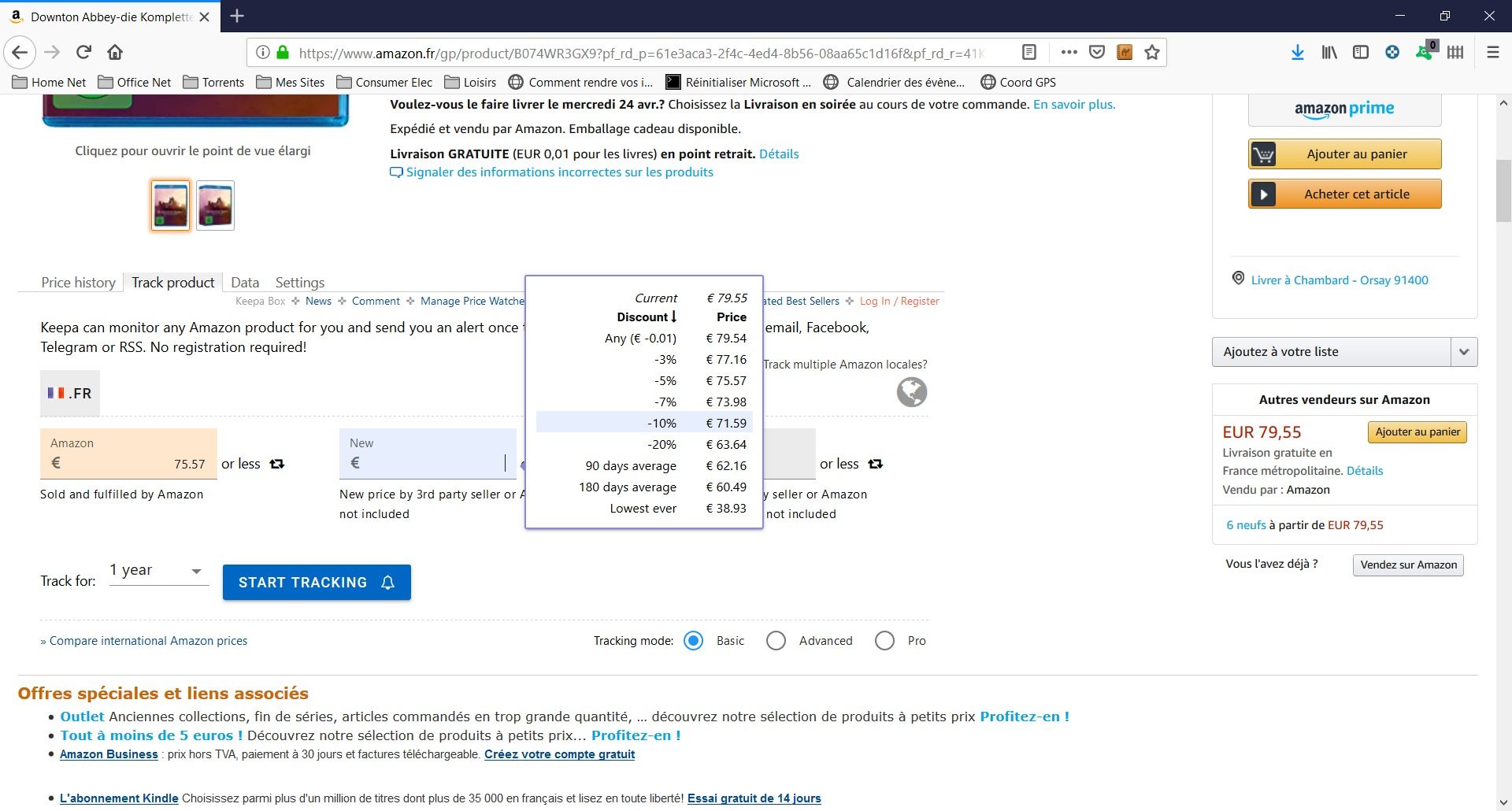

Il est possible de placer des alertes en fonction de l'évolution (à la baisse) des prix. Pour cela, il faut cliquer sur l'onglet "Track Product" au dessus du graphique des prix et de configurer ses alertes. Dans l'exemple suivant, je positionne une alerte dès que le prix Amazon descend en dessous de 75,57 €. Et je fixe à -10% l'alerte pour un prix à neuf d'un fournisseur tiers (Amazon compris). Ne reste plus qu'à cliquer sur "Start Tracking".

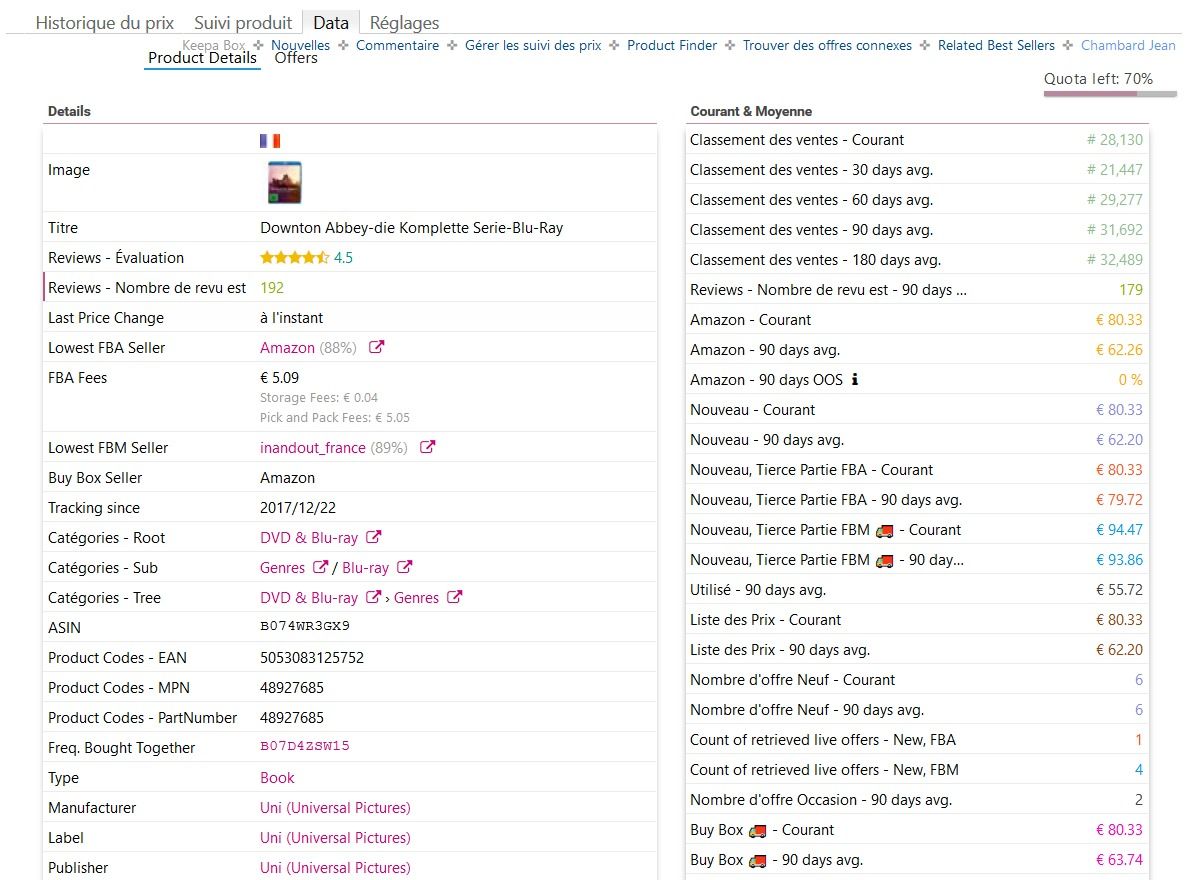

Enfin, pour les acharnés, il existe un onglet "Data" qui permet de visualiser toutes sortes de données conservées par Amazon, et utilisées pour fixer les prix.

Je vous fais grâce de l'onglet "Settings" ou "Réglages" qui permet de paramétrer ses préférences, dont la langue de l'add-on que j'ai laissé en anglais et que j'ai passé en français pour la fin de ce billet.

2 - Les prix selon CamelCamelCamel

CamelCamelCamel (non, ce n'est pas une erreur de frappe, oui l'auteur du site devait aimer les chameaux) est plus récent que Keepa, et cela se voit un peu. Il y a même un peu trop de publicité à mon goût. La barre de recherche est en revanche directement accessible...

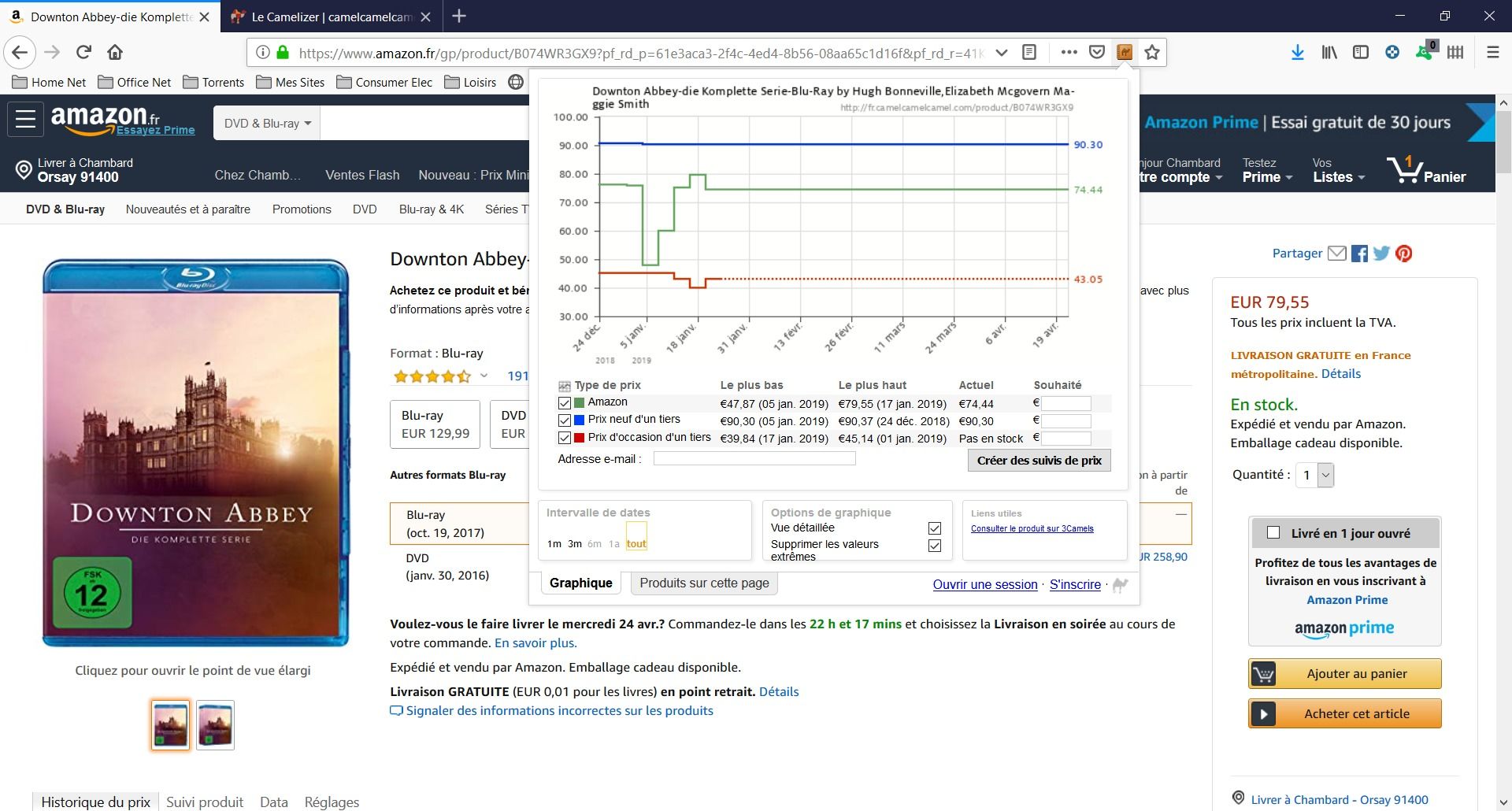

Là encore, il vaut mieux passer par l'extension de son navigateur, appelé The Camelizer.

Une fois l'extension installée, une petite icône apparait au bout de la barre d'adresse de votre navigateur, juste à côté de l'étoile pour marquer ses favoris.

Les graphes de Camelizer sont plus simples et plus lisibles grâce à l'emploi de la couleur : vert pour Amazon, bleu pour prix neuf un tiers, rouge pour une occasion. On peut aussi cocher ou décocher ces cases, ce qui permet de faire évoluer le graphe dynamiquement.

Ce qui est dommage, c'est qu'il faille aller chercher cette icône en haut de l'écran du navigateur, au lieu d'avoir le graphe intégré à la page d'Amazon. C'est mon plus gros regret au sujet du Camelizer.

Sinon, pour créer une alerte sur un prix, rien de plus simple. Dans cette même page, saisissez un prix souhaité dans la dernière colonne (il faut calculer le pourcentage vous-même malheureusement), votre adresse e-mail et cliquez sur "Créer des suivis de prix". Voilà, c'est simple comme un clic de souris.

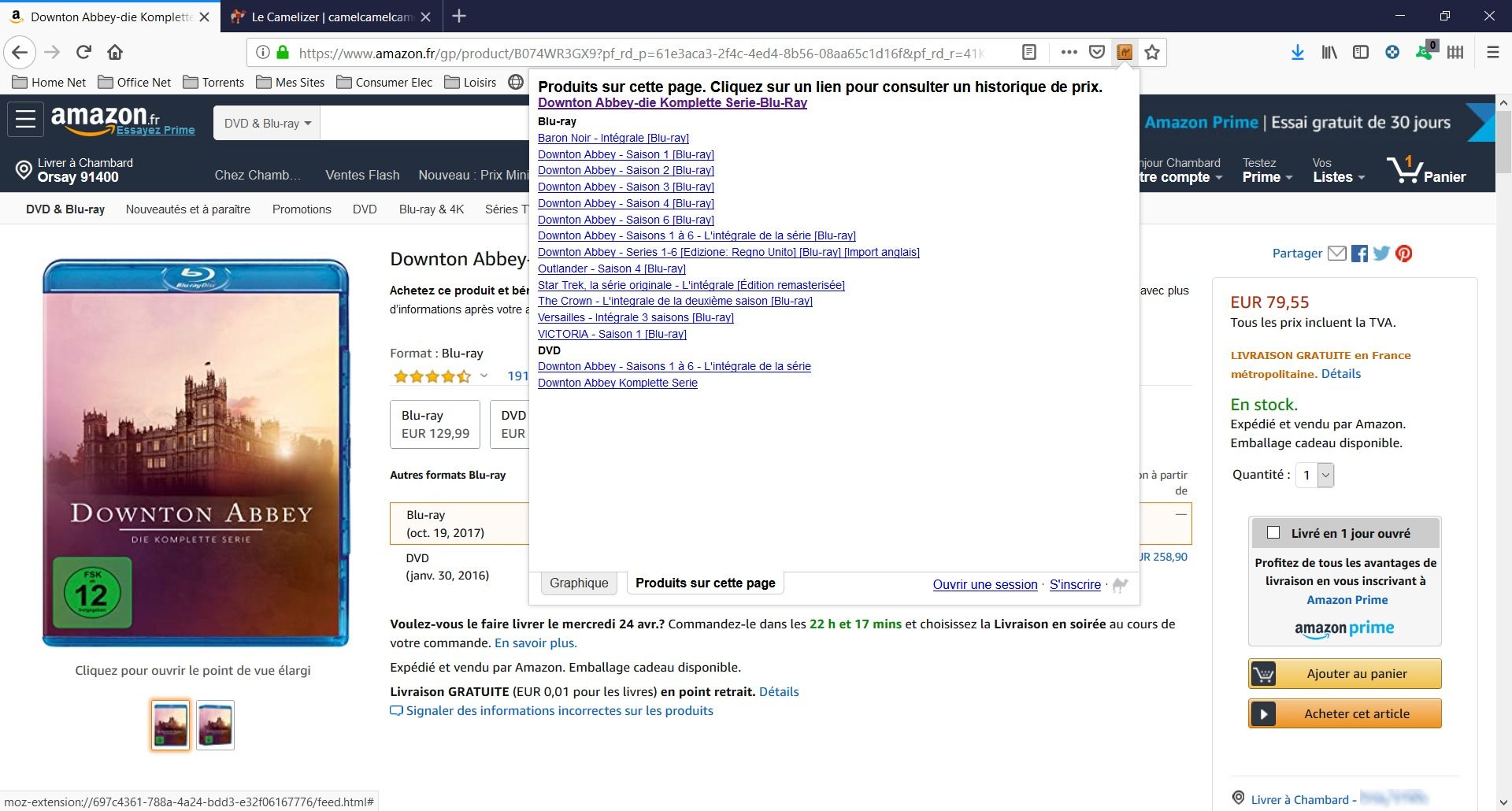

Enfin, l'onglet "Produits sur cette page" vous donne les liens directs des produits connexes qu'Amazon ne manque jamais de vous afficher.

3 - Keepa ou CamelCamelCamel

Keepa est probablement l'outil le mieux intégré à Amazon, et le plus puissant. Mais pour ceux qui aiment la simplicité, CamelCamelCamel est fait pour eux. Même si Il n'affiche pas toujours les bons prix. Si vous avez bien regardé les copies d'écran de Camelizer, vous aurez sans doute remarqué qu'il affichait un prix de 74,44 € alors que le prix réel s'affiche juste à côté et est de 79,55 €. Le fait est que la mise à jour du graphique de CamelCamelCamel laisse à désirer.

Pour la justesse des informations et l'intégration, j'ai pour ma part choisi Keepa.

4 - Amazon et au-delà

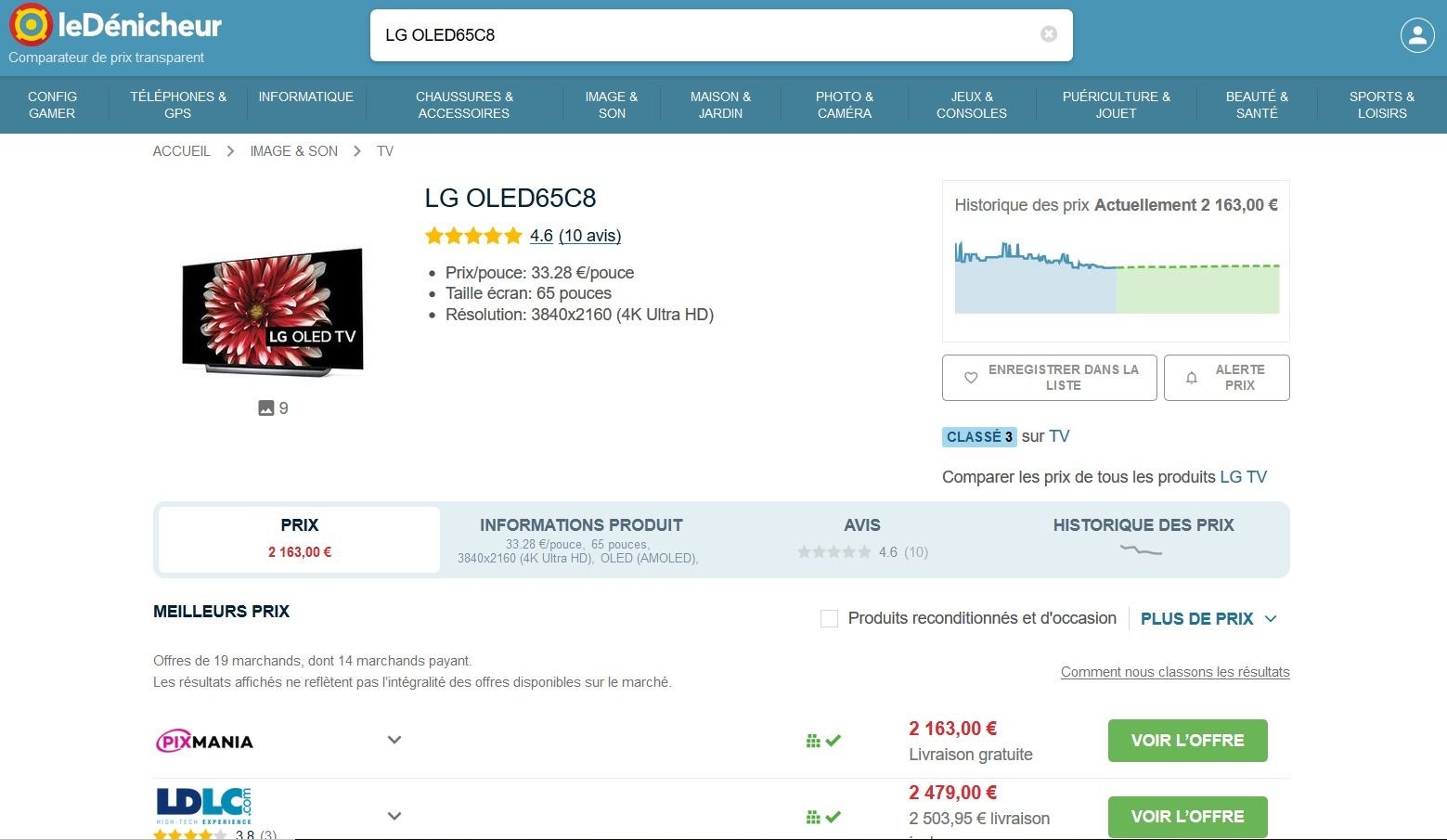

Pour ceux qui ont une vie en dehors d'Amazon, il existe d'autres sites de suivi des prix comme Le Dénicheur par exemple.

En cherchant un produit référencé par Le Dénicheur, on peut afficher l'historique des prix, la tendance ainsi que positionner une alerte en cas de baisse des prix en dessous d'un certain seuil. Une bonne alternative pour se désintoxiquer d'Amazon...

N'hésitez pas à me faire part de vos remarques sur ces outils ou sur d'autres que vous jugez intéressants.

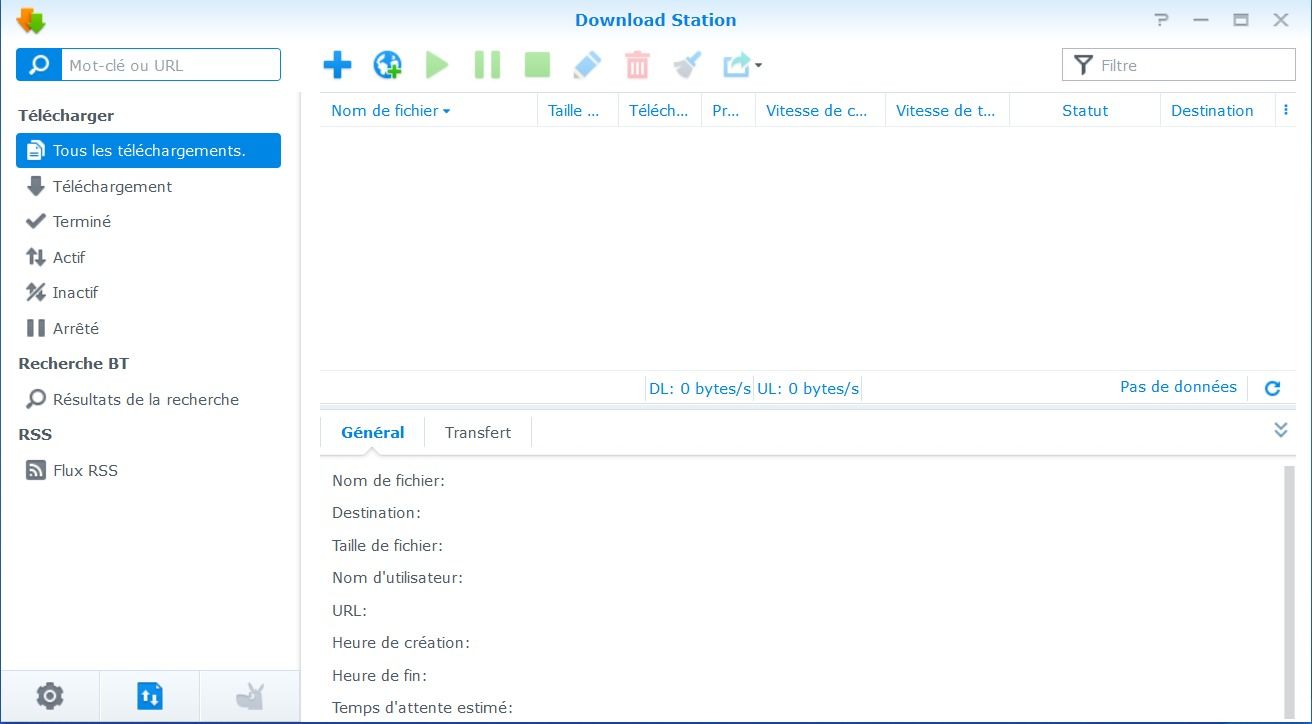

Synology : ajouter un moteur de recherche à Download Station

Paris, le 21 avril 2019

Dans un long article sur la configuration d’un NAS Synology, j'avais parlé rapidement de "Download Station", le client qui permet de déclencher des téléchargements directement depuis votre NAS. vous permettant de télécharger (légalement j'espère) logiciels, films et musiques sans surchager votre réseau Wifi, et sans laisser votre PC allumé toute la nuit. J'avais notamment évoqué la possibilité de rajouter des moteurs de recherche Bit Torrent, Synology étant un peu avare par défaut.

Je vous présente donc ici la méthode pas à pas pour configurer un moteur de recherche Bit Torrent dans Download Station.

1 - Pourquoi un moteur de recherche

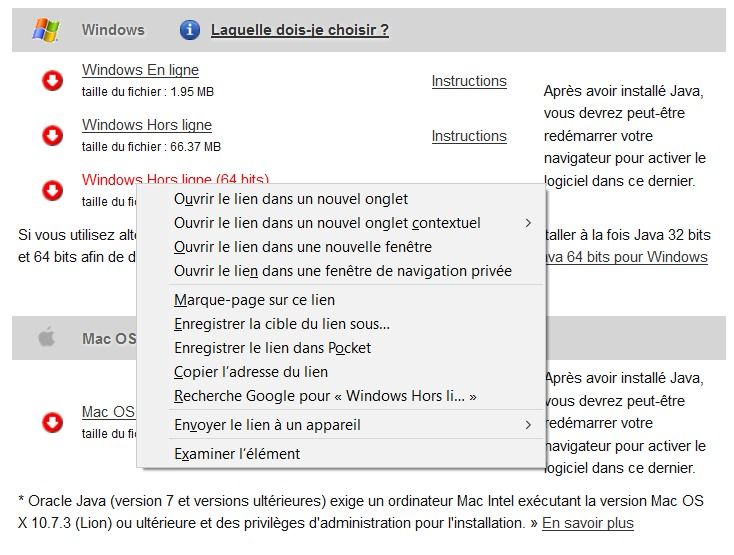

Pour télécharger un fichier depuis "Download Station", il suffit de coller l'URL cible dans le champs de recherche, situé en haut à gauche. La Station s'occupe ensuite du reste. Et pour obtenir cette fameuse URL, rien de plus simple. Il suffit en effet d'utiliser votre navigateur préféré. Essayons par exemple d'installer Java JRE 64 bits pour Windows. Pour cela, il faut se rendre sur le site Oracle dédié à Java sur la page de téléchargement manuel : https://www.java.com/fr/download/manual.jsp.

Il suffit alors de se positionner sur la ligne "Windows Hors ligne (64 bits)" et de cliquer sur le bouton droit de la souris pour faire apparaître le menu contextuel. Ne reste plus qu'à sélectionner "Copier l'adresse du lien" et de coller ce lien dans le champs de recherche de Download Station.

C'est simple mais ce n'est pas très pratique. Il faut faire sa recherche manuellement, copier-coller l'adresse et démarrer enfin le téléchargement. C'est pourquoi il est souvent plus simple de passer par un moteur de recherche Bit Torrent.

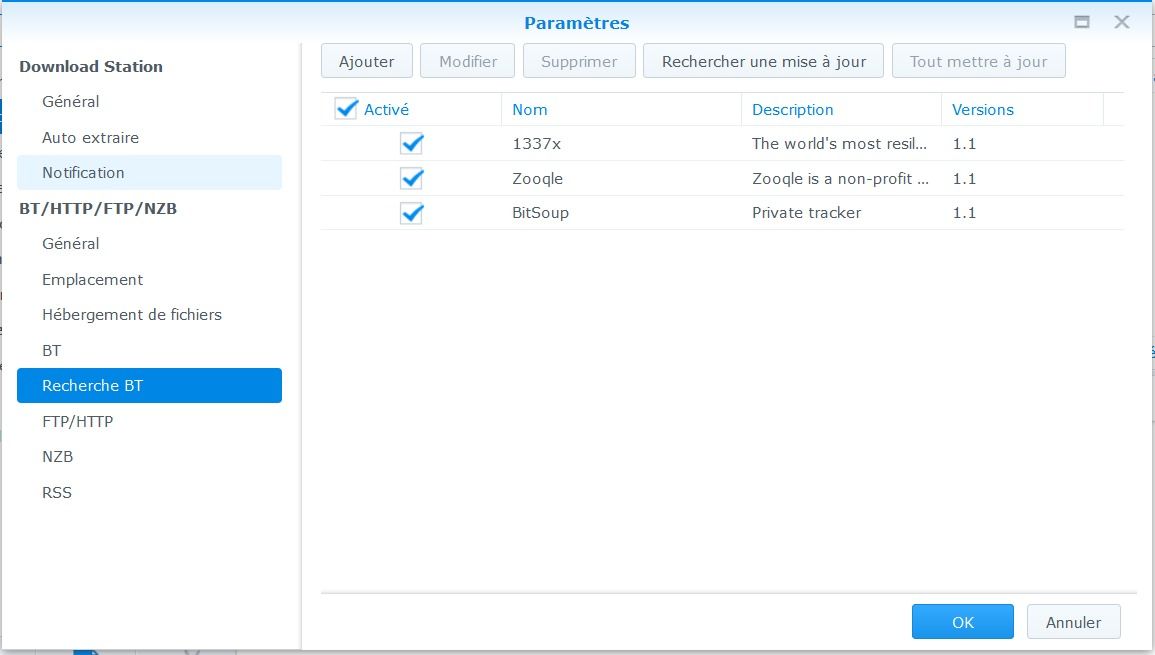

2 - Paramétrage des moteurs de recherche BT

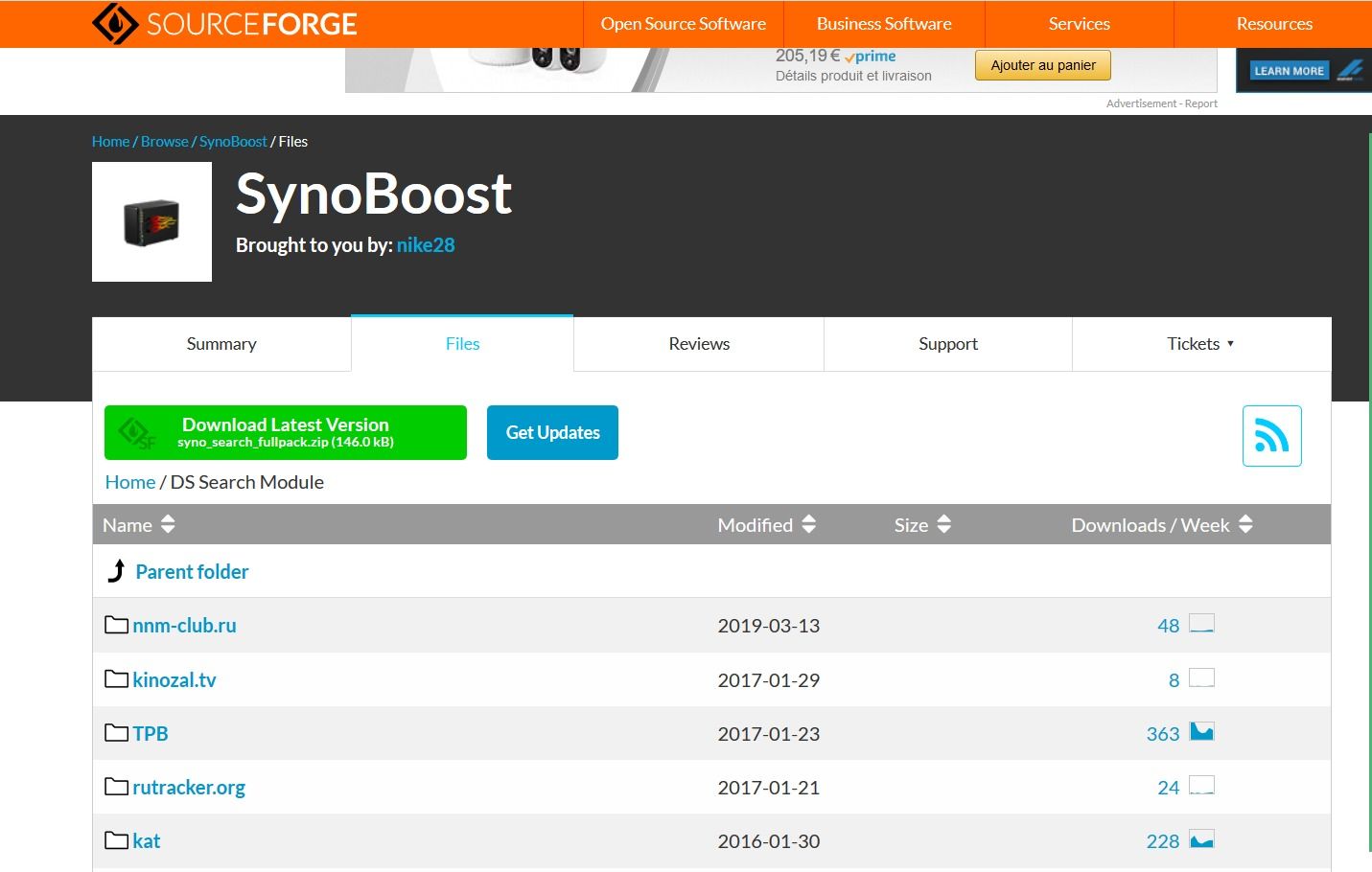

Créer un moteur de recherche BT pour Synology réclame un peu de compétences. heureusement, la communauté met à disposition des ressources bien utile. Rendez-vous sur SourceForge sur la page de SynoBoost, à l'adresse suivante : https://sourceforge.net/projects/synoboost/files/DS%20Search%20Module/

Sélectionnez le moteur de recherche qui vous intéresse. Je sais, il y en a beaucoup, mais vous pouvez utiliser les différentes colonnes pour trier les moteurs disponibles. Une fois votre choix fait, téléchargez le fichier zip correspondant dans un répertoire de votre PC. Vous pouvez aussi télécharger la totale, le full pack. Attention néanmoins, certains moteurs de recherche nécessite que vous installiez un serveur Web comme Web Station pour fonctionner. Lisez attentivement les instructions d'installation pour chaque moteur.

Décompressez le fichier zip pour en extraire le fichier "dlm" qui contient les paramètres du moteur de recherche. Réservez comme dirait Top Chef...Autrement dit, gardez-le de côté.

Connectez vous maintenant à votre NAS Synology à travers son interface Web et lancez Download Station. La page d'accueil du client s'affiche.

Pour les habitués de Synology, vous remarquerez que l'icône des paramètres a migré en bas à gauche de l'écran (et c'est plus logique de la trouver là que dans la barre des outils liés aux téléchargements eux-mêmes). Cliquez sur l'icône "Paramètres", symbolisé par le petit engrenage que l'on retrouve partout.

La page des paramètres s'affiche. Cliquez sur l'onglet "Recherche BT". Les moteurs de recherche Bit Torrent existants s'affichent.

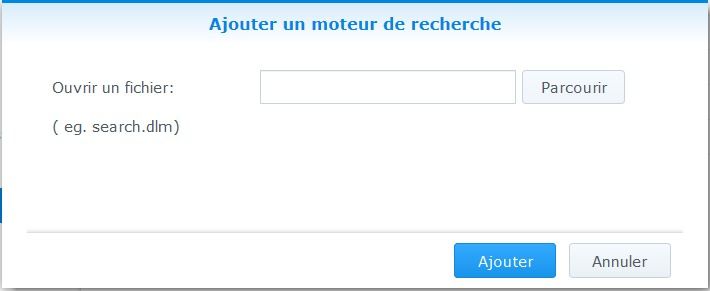

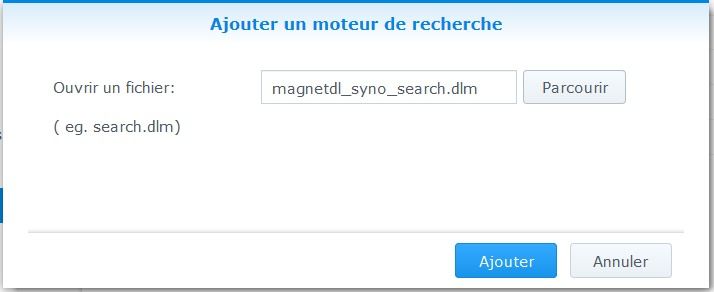

Cliquez sur "Ajouter" pour ajouter un moteur de recherche (c'est logique). La fenêtre de dialogue suivante s'ouvre.

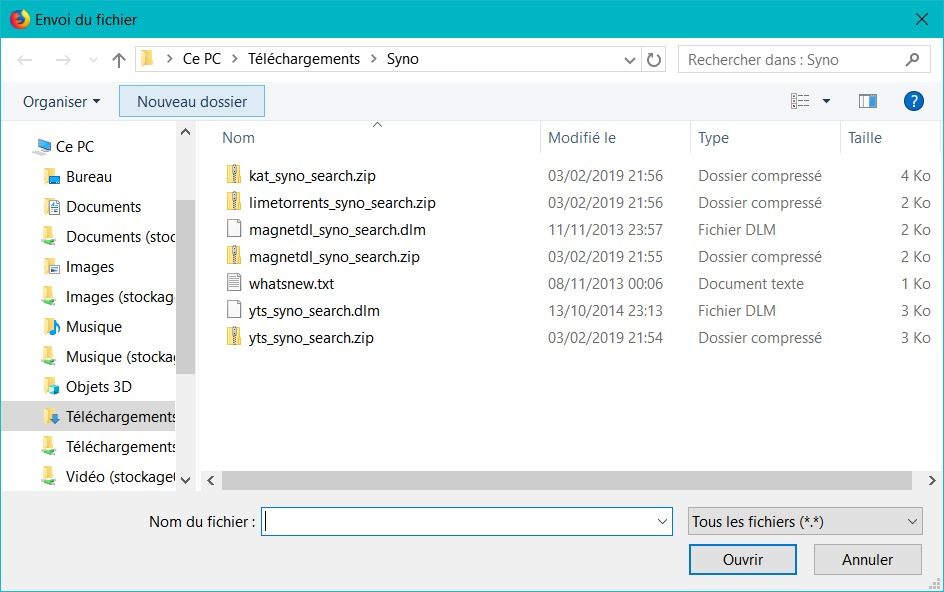

Cliquez sur Parcourir et naviguez jusqu'au répertoire dans lequel vous avez sauvegardé votre moteur de recherche. Sélectionnez le ou les fichiers dlm désirés.

Dans mon exemple, je sélectionne magnetdl.dlm

Reste à valider pour que le moteur de recherche soit ajouté dans la liste des moteurs actifs. Il est alors possible de rechercher par mot clés à travers les divers moteurs de recherche disponibles.

Et pendant que Download Station télécharge pour vous, n'oubliez pas de profitez de la vie...